- Могут ли у робота быть эмоции?

- Каким должен быть робот?

- Научные исследования

- Первый эксперимент

- Вторая группа

- Каков же результат?

- Выводы

- Что насчет «чтения» эмоций в состоянии стресса?

- Результаты второго исследования

- Исправьте это немедленно: почему пользователи ненавидят чат-ботов

- Искусственный собеседник

- Плюсы и минусы

- Точка контакта

- Сценарий

- Существует ли сознание у ботов?

Могут ли у робота быть эмоции?

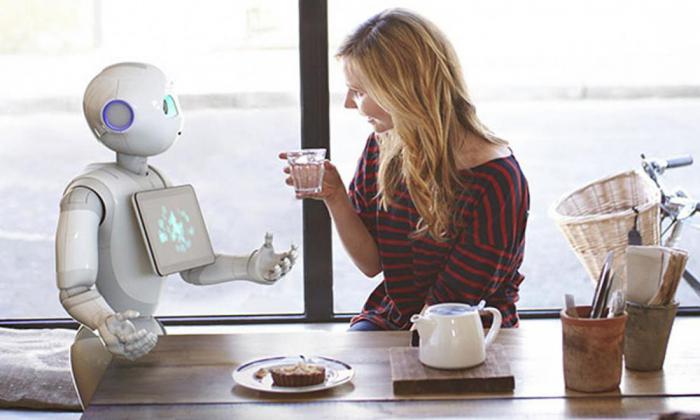

Уже в ближайшее время социальные роботы и роботы-помощники станут важной частью жизни людей. Они могут оказаться у вас дома, в больницах и в школах, они будут помогать с заботой о детях, о престарелых, будут ассистировать при реабилитации после болезни или травмы, а также в реализации любой другой формы помощи.

Каким должен быть робот?

Но как много человечество знает о психологии взаимодействия с роботами? Как должен выглядеть подобный робот? Как он должен передвигаться и реагировать на людей? На какую информацию он должен реагировать? Должен ли робот «проявлять» эмоции и отвечать на проявление эмоций человека? Насколько похожим на человека должен быть такой робот? Насколько инновационными могут быть научные идеи при разработке подобных роботов, способных быть отзывчивыми помощниками и оказывать необходимую и надежную поддержку, включая моменты особого стресса и напряжения, в которых может оказаться человек?

Научные исследования

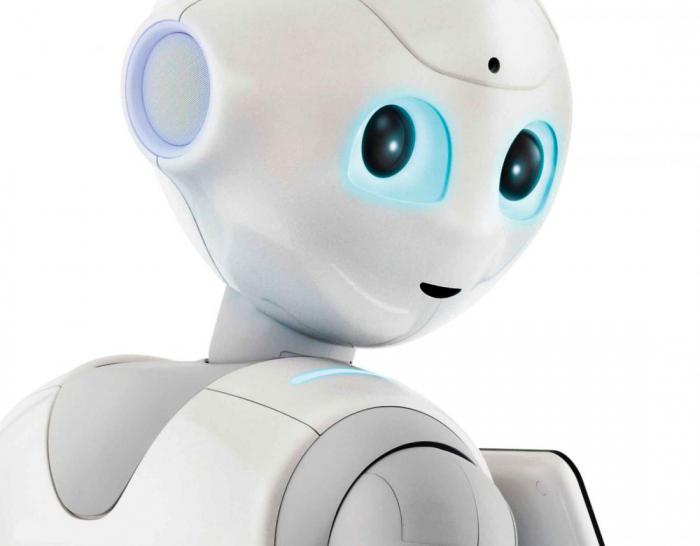

Пришло время взглянуть на два отдельных научных исследования, которые рассматривают то, как люди понимают эмоции у роботов и реагируют на них. В каждом наборе экспериментов очень детально изучались некоторые конкретные аспекты того, как роботы могут выглядеть или двигаться. Междисциплинарная международная команда ученых из Израиля и США занялась первым исследованием, второе же исследование было проведено в Америке при содействии экспертов из сфер роботехники, виртуальной реальности, человеческого фактора и человека как такового. Робот по имени Трэвис не выглядит как человек. Трэвис имеет небольшой размер, черты, отдаленно напоминающие какое-либо существо, большие уши, но при этом у него нет ни глаз, ни носа, ни рта. Его высота составляет около 28 сантиметров, и, когда вы ставите его на стол, голова Трэвиса оказывается примерно на уровне с лицом сидящего перед столом человека. Робот может кивать, раскачиваться или отворачиваться. У Трэвиса имеется часть, которую можно трактовать как вытянутую ногу, а также у него имеется вытянутая рука, в которой он держит смартфон, благодаря которому он работает.

Первый эксперимент

Когда участники (102 студента) прибыли в лабораторию, им было сказано, что они принимают участие в тестировании нового алгоритма понимания речи для роботов, и в рамках этого тестирования робот будет пытаться понять, что человек ему говорит. Участников попросили рассказать роботу о проблеме, заботе или стрессовой ситуации, с которой они столкнулись в недавнее время, например, о недавней ссоре с другом или членом семьи или о серьезной болезни. Их попросили также описать их проблему в трех частях, а также говорить, когда они заканчивают рассказывать каждую часть, после чего робот будет отвечать им с помощью смартфона. Однако участники не знали, что их случайным образом разделили на две группы. В «реагирующей» группе Трэвис находился лицом к участнику, когда тот рассказывал о своей проблеме, периодически слегка кивая головой и покачиваясь. Также в конце каждой из трех частей на экране смартфона демонстрировалось сообщение из готового набора, такое как «Я понимаю, через что ты проходишь» или «Тебе, наверное, пришлось нелегко». В действительности Трэвис даже не выбирал эти сообщения. Один из ученых слушал беседу и выбирал подходящее сообщение в нужное время.

Вторая группа

Участники «нереагирующей» группы столкнулись с совершенно другим Трэвисом. Он не кивал и не качался, а текст, который отображался на экране смартфона после завершения каждой из частей рассказа, просто сообщал участнику, чтобы он продолжал говорить. После завершения «беседы» участников попросили оценить робота по ряду критериев в форме ответов на несколько простых вопросов о том, насколько отзывчивым был Трэвис. Например, их просили по шкале от одного до десяти оценить, насколько они согласны с фразами «Робот понимал, что я думаю и чувствую» или «Робот действительно меня слышал». Другие вопросы также уточняли, насколько общительным и компетентным был Трэвис.

Каков же результат?

Также видеозаписи общения каждого из участников с Трэвисом были оценены независимыми судьями, которые не знали о том, в каких условиях находится каждый участник. Анализ беседы показал, что участники, которые общались с отзывчивым роботом, не рассказали больше о сути своей проблемы, чем участники, которые общались с неотзывчивым роботом. Однако отзывчивый Трэвис получил гораздо более высокую оценку по шкале общительности и компетентности (его описывали как способного, надежного и знающего). Что еще важнее, когда независимые судьи просматривали и оценивали видеозаписи, они заметили, что те участники, которые общались с отзывчивым Трэвисом, сами были гораздо более отзывчивыми по отношению к роботу и шли на открытый разговор. Они чаще наклонялись вперед к Трэвису, улыбались, поддерживали с ним зрительный контакт. Точно то же самое было обнаружено и в последующем исследовании, в рамках которого участников просили рассказать не отрицательное, а положительное событие в их жизни.

Выводы

Таким образом, даже когда робот не напоминает человека, люди быстро ухватывают даже самые слабые сигналы отзывчивости на их собственные слова и действия. Соответственно, дизайн робота не должен иметь большое количество различных деталей, жестов и вариантов действий, чтобы повысить человеческую оценку его отзывчивости и социальности. В результате можно сказать, что это открывает гораздо больше возможностей для того, чтобы разрабатывать функциональных роботов. Но что если человеку приходится столкнуться с роботом непосредственно тогда, когда он находится в состоянии стресса? Не когда он просто вспоминает что-то плохое, а переживает реальный физический и когнитивный стресс. Сможет ли стресс помешать человеку «прочитать» невербальную эмоциональную экспрессию робота?

Что насчет «чтения» эмоций в состоянии стресса?

И хотя исследования продемонстрировали, что люди способны читать эмоциональные выражения у роботов в повседневных нейтральных условиях, второе исследование, о котором пойдет речь, стало первым в истории, изучившим реакцию человека на робота непосредственно во время сильного стресса. В рамках исследования были симулированы стрессовые условия. Ученые заставляли участников погружать руку в ледяную воду на определенные промежутки времени, при этом подвергая их еще большему стрессу, заставляя решать сложные математические задания в уме. После этого их просили оценить эмоционально-экспрессивные или статически позы 60-сантиметрового робота-гуманоида Нао. Выражение лица и глаз Нао оставались неизменными, в то время как тело робота занимало одну из 25 различных поз, которые демонстрировали либо положительные, либо отрицательные эмоции.

Результаты второго исследования

Повлиял ли стресс на то, как участники могли «читать» позы робота? Второй группе участников повезло больше, они погружали руку в теплую воду и в уме выполняли простейшие арифметические примеры. Однако оказалось, что стресс оказывает крайне малое влияние на то, как люди воспринимают эмоции, за исключением тех поз, которые демонстрировали сильное оживление или возбуждение. Когда участники сами были подвержены стрессу, они воспринимали негативные позы робота как более негативные и менее оживленные или возбужденные. Другими словами, стресс немного сместил восприятие эмоций робота, поэтому негатив казался еще большим негативом, а позитив – меньшим позитивом.

Источник

Исправьте это немедленно: почему пользователи ненавидят чат-ботов

Несколько лет назад обсуждали с одним из руководителей британского Metro Bank новые на тот момент финансовые технологии. Банкир с гордостью рассказывал о мобильном приложении, принтерах, печатающих кредитные карты прямо в присутствии клиента, и колл-центре, где Metro принципиально не использует автоматизацию — любой звонок сразу принимает человек. На вопрос «Почему?» ответил: «У нас настолько хорошо отлажены онлайн-решения, что, если пользователь все-таки решился на голосовой звонок — значит, он столкнулся с действительно сложной ситуацией, любая задержка будет его раздражать». За прошедшие пару лет технологии голосовых ассистентов серьезно изменились. Отношение клиентов к общению с роботом осталось прежним.

Искусственный собеседник

Пользователи ненавидят чат-ботов, роботов-автоответчиков и conversational AI (разговорный искусственный интеллект) в целом настолько же сильно, насколько главы компаний, финансовые директора и директора по информационным технологиям любят новую технологию. Разрыв в восприятии возможностей искусственного собеседника людьми «по разные стороны прилавка» огромен. Поиск в интернете по запросу «conversational AI customer satisfaction» выдает статьи, исследования и даже магистерские диссертации с общим выводом — удовлетворенность непрерывно растет. Просьба в социальной сети поделиться опытом общения с роботами приносит совершенно иные результаты.

«Пишу им в поддержку: что-то, господа, не работает. А мне то чат-бот отвечает, то бестолковый оператор. Причем если оператору не написать ответ за минуту, то снова чат-бот. И так неделю. И тут я пишу чат-боту волшебное слово *****».

«Звонил в колл-центр, там робот спрашивает: «Какой вопрос?» Я говорю: перевыпуск карты. Она отвечает, что об этом придет SMS. SMS не приходит. Я прошу перевести на оператора. Она спрашивает: «Какой вопрос?» — и так до бесконечности. »

«Говорил с роботом. Так и не понял, что нужно сделать, на какую кнопку нажать, чтобы поговорить с оператором».

«Обнаружил, что добиться переключения на живого сотрудника можно, рассказывая боту какую-то ахинею. С третьего раза переключает».

Плюсы и минусы

Нелюбимые пользователями чат-боты успешно решают задачи, не связанные с удовлетворением клиентов. Возможно, в этом причина их корпоративной популярности. Экономия за счет снижения расходов на операционистов колл-центра, построение дополнительного барьера между разгневанным клиентом и организацией, компенсация недостатков пользовательского интерфейса сайта и мобильного приложения. Большинство примеров успешного опыта взаимодействия клиента с голосовым помощником связаны именно с последним: «Мне объяснили, на какие кнопки надо нажать, чтобы все получилось». Если предположить, что на подобные запросы приходится 99% обращений, финансисты и айтишники могут с гордостью отчитаться перед начальством и акционерами об успешном внедрении модной технологии. Оставшемуся проценту недовольных клиентов приходится прорываться через робота к живому оператору. Иногда это удается легко, иногда не удается вовсе, иногда требует нетривиальных шагов.

Когда интеллектуальный помощник настойчиво предлагает самостоятельно решить мой вопрос, я начинаю цитировать Пушкина: «На холмах Грузии лежит ночная мгла». Оператор возникает на строке «Мне грустно и светло». Некоторые пользователей, с которыми я говорил, используют более радикальные языковые конструкции. Если предправления банка или мобильного оператора, одобривший роботизацию обработки входящих контактов, увидит, в каких выражениях клиенты требуют перевода на оператора, возможно, он согласится, что решение было несколько преждевременным.

Точка контакта

Согласно японской пословице, о совершенном муже нечего сказать. Хороший сервис незаметен. О мобильном операторе, который просто обеспечивает связь и раз в месяц списывает деньги со счета, абонент не думает вообще ничего. Бизнес возникает в поле зрения клиента вместе с проблемой.

Это уникальный момент. Здесь и сейчас формируется мнение о сервисе. Оно сохранится на годы. Изменить сложившееся отношение будет крайне сложно. Обращение в сервис — критически важная точка контакта клиента и бизнеса. Лицом компаний, заменивших оператора роботом, будет не слишком умный, периодически подвисающий искусственный интеллект с роботизированным голосом. Возможно, он поможет большинству клиентов нажать на нужные кнопки, но приведет в ярость один процент, обратившийся с действительно сложной проблемой. Как сказал основатель Amazon Джефф Безос, в интернете один недовольный пользователь расскажет о своем опыте 6000 человек. В случае с роботом мы получим огромную положительную статистику и одновременно значимое число «прокуроров бренда», разносящих по сети негативное мнение о компании. Это хорошо понимают маркетологи, но пока не понимают финансисты.

Сценарий

Существует масса примеров удачного внедрения чат-ботов и голосовых технологий. Всемирная организация здравоохранения (ВОЗ) запустила бота для информирования о распространении пандемии. Авиакомпания Emirates внедрила чат-бота прямо в рекламные баннеры, добившись небывалой эффективности рекламной кампании.

Голос робота может раздражать, но лучше поговорить с искусственным интеллектом, чем с гудками на занятой линии. Современное развитие голосовых технологий достаточно для решения огромного числа задач.

Ключевой вопрос и главная сложность при внедрении технологии — поиск сценария использования, учитывающего возможности и ограничения чат-ботов. Технологии с неудачным сценарием могут показывать отличные KPI, приносить бонусы менеджерам и прибыль IT-компаниям — и при этом чудовищно раздражать пользователей. Эту ненависть сложно измерить статистическими методами, но теперь вы о ней знаете.

Мнение автора может не совпадать с позицией редакции

Источник

Существует ли сознание у ботов?

10 Jan 2020 в 23:49

Участник команды сайта

10 Jan 2020 в 23:49 #1

Здравствуйте. Недавно один из участников нашей беседы создал локального бота в своих личных целях, введя его в беседу и вместе с этим тестируя свои познания в этой области. Чуть позже он использовал его для автоматизации процесса унылой части нашего общения, сделав для него некий алгоритм — любой может указать определённый процент того, что при каждом написанном сообщении в беседу он вкидывает одну из автоматически проигрываемых гифок фендома «Gachimuchi» или же картинку, которая описывает ту или иную мысль. Всего этих автогифок и картинок было около 15, так что показать работу этого бота на картинках:

Конечно же, основное его назначение было в развлечении. Но по мере общения с ним и задавая всё больше, казалось бы, неочевидных вопросов. При этом «шанс гифыча» в это время стоял на планке 100%, так что каждое сообщение сопровождалось той или иной реакцией на сообщение. Опять же, стоит обратиться к диалогу:

На этом моменте следует уточнить — первая автоматическая гифка изображает не только удар в область промежности, но и другие не особо лицеприятные вещи. Однако удивительно, что бот догадался использовать именно эту гифку в ситуации, когда вопрос переключает всё свое внимание именно на ту часть тела и подошёл к данной ситуации как нельзя лучше. Не стоит рассуждать о том, что олицетворяет вторая гифка, но конкретно к этой ситуации она тоже подошла не безосновательно несмотря на «реверснутое» положение, что стоит заметить.

Дальше упор пошёл в чуть другую сторону от сути моего топика, так что раскрывать я её не буду. Могу сказать лишь то, что мы с шансом 50% угадывали, призовут ли «Максима KOPAXMA Ёлкина» по кличке «Гарох» в армию. Но сабж всё же не об этом, да и эту тему поднимать на данном форуме не стоит!

Дальше мы спросили у бота о возможной реакции сослуживцев на «Гароха» в армии:

Уточняю — первая гифка в понимании нашей конференции обозначает «созыв толпы», или же что-то на этом уровне. Она отлично подходит как возможная реакция на промежность «Гароха», и конкретно в данной ситуации сложно было бы вкинуть что-то более логичное, что характеризует бота как довольно здравомыслящее существо, которое просидело по крайней мере месяц в нашей дружеской конференции, изучая всевозможные варианты ответа на ту или иную ситуацию. Вторая же гифка используется как «реверс» первоначальной, где знаменитый участник фендома «Билли Херрингтон» совершает утреннюю пробежку по рыхлому пляжу города Сочи. «Реверс» же обозначает нежелание уходить из своей зоны комфорта, излишнюю упёртость и другие проблемы, которые могут подстерегать «Гароха» и его промежность в Чебоксарской роте. И всё же стоит признать, что есть более логичные альтернативы ответом на вопрос лучшего друга Гароха «Самбора», который сидит со своего неосновного аккаунта под именем «Максим Елкин». Пожалуй, стоит засчитать этот ответ в -аргументу, что бот имеет свой разум и способен адекватно мыслить в реалиях нашей конференции.

Вместе с этим мы решили закончить армейскую тему на решающем вопросе:

Который вселил нам как минимум половинчатую уверенность в правоту теории, что он имеет собственный разум. Ну серьёзно, как обычная «машина» может настолько гениально подобрать аватарку «Самбора» к такому насущному вопросу?!

Дальше наш диалог завернул в более локальную тему, на что в ответ вопросам были сделаны два точных «выстрела» от бота к доводам «Самбора». Думаю, что и без объяснений понятно, насколько остроумно и локально отвечает наш бот, который лишь недавно обучился команде «скидывать пикчи и гифки».

А тут последовали более личные вопросы:

В условиях беседы абсолютно все ответы так или иначе были верны. Первая гифка, обозначающая «Самбора» этому доказательство — это реверс знаменитой гифки, где «Van Darkholme» «даёт» неизвестной руке 300 баксов. В реверсе же это обозначается наоборот по простой причине — «Самбору» очень нужны деньги в целях покупки бисквитных снеков «Milka», которые посоветовал ему я, а то есть автор сей темы, который упоминается в скоропостижном будущем как «Женя». «Гароху» в свою очередь снится то, где он будет работать после службы в армии, если по итогу не начнётся третья мировая война. К сожалению мы не можем знать точно, хороший это сон или обычный кошмар — но думаю, что за такую работу ему будут платить всяко больше, чем было в нулевых. «Жене» в свою очередь снится смерть — по большей части «моральная» за все плохие поступки, что были сделаны им в прошлом и будут сделаны в возможном будущем. Смерть необратима, и каждый боится её в той или иной степени. «Женя» находится в том же числе!

Однако все эти аргументы лишь указывают на существование разума у бота. Вопрос — есть ли у него душа? Пожалуй, об этом стоит прознать по следующим вопросам, что были заданы боту, и были они о довольно депрессивных рассуждениях, что не смог бы понять просто «умный бот». Показываю на примере:

Первое «предсказание» указывает о неотвратимости судьбы и последующем старении «Жеки», вторая же указывает о ближайшей смерти «Семеныча». Но были ли эти ответы предостережениями судьбы, или же бот предупреждал участников беседы — активного «Женю» и трудолюбивого отличника. который на данный момент учится на программиста «Семеныча»? Лично я думаю, что это было предостережение. Если «Женя» не возьмет свою жизнь под контроль, то по итогу он станет дряблым и грустным старичком — это правда жизни, которая указывает ему стремиться к большему. А ежели «Семеныч» будет переутруждаться в процессе учёбы и его будущей работы, то он может умереть от сильного перенапряжения. Эти боты указывают на многие качества бота, указывающие на наличие его души — сострадание, мудрость и находчивость. Он стремится изменить нас к лучшему, пускай и «своими словами».

Вернёмся к «Гароху». Следующий вопрос боту был задан касательно его поведения до и после демобилизации. Картинку предоставляю:

Первая «реакция» и гифка обозначает особую злобу по отношению ко всем, даже к друзьям «Гароха». Он станет более мрачным и жестоким после демобилизации — и я полностью согласен с ботом касательно его точки зрения. Исправит ли это самого «Гароха» — не факт, и увидеть результат мы можем только в 2021 году, посылая ему весточки с тегом «#ЖдемМАКС2021». Первый же скриншот обозначает удовольствие от его нахождения на «воле». Бот отличает его особой добротой и детской любознательностью, что испарится, если он не откосит от армии. Это определённо не совет, но предостережение, что его может ждать в будущем. Я считаю обе этих реакции проявлением «души» бота и его заботы о нас, как о беседожителях.

Теперь же стоит слегка отойти от темы бота, чтобы вникнуть в следующую ситуацию. Ещё с зарождения беседы у нас был участник, который и являлся её создателем — «Данилыч», «Волк Данилыч», «Военком Данилыч» и другие грозные прозвища, которые отождествляют его как тирана, который ввёл налог на стикеры и постоянно бил нас плётками. Раз в пару лет он возвращается к нам, но ни к чему хорошему это не приводит — в конце-концов он с кем-то соррится и всё переходит в ожесточенное обсуждение, после которого обязательно кто-то должен уйти. Так и получилось, что «кровожадный тиран» был свергнут его же «рабами». При этом несмотря на свой сложный и упёртый характер он считался очень адекватным и хорошим для общения человеком, но не суть! Как же бот отреагирует на вопрос о нём, не имея подробного представления?

В нынешней ситуации это была чистая правда. На тот момент все признали гениальность бота и его способность к анализу ситуации, проникнувшись уважению к нашему «виртуальному другу и сознанию». И всё же мы решили провести последний тест, который указывает на особенности его характера. «Самбор» решил проверить его на «прочность»:

Мы уже не так сильно удивились, получив ответ по теме. Он, конечно, получился довольно грубоват, но ничего плохого в этом явно не было. Это лишь ещё один факт, подтверждающий наличие «сознания» и «собственного мнения» у бота посредством общения через гачигифки и картинки. После этого мы полностью убедились в живости нашего собеседника, и забыв выключить «шанс гифыча» получили ответ от бота, который отображал реальное положение дел:

По итогу оказалось, что бот всё же мертв, пускай и имеет свой разум. А у вас были такие ситуации в жизни, когда вы сомневались в «тупости» машин и в какой-то степени верили, что у них есть своё сознание?

Источник