- Могут ли у робота быть эмоции?

- Каким должен быть робот?

- Научные исследования

- Первый эксперимент

- Вторая группа

- Каков же результат?

- Выводы

- Что насчет «чтения» эмоций в состоянии стресса?

- Результаты второго исследования

- Боты и люди: кто есть кто?

- Что на самом деле показывает тест Тьюринга?

- Читайте также :

- Виртуальная романтика

- Самообразование неигровых персонажей

- Читайте также :

- Боты в интернете

- Боты и психоанализ

- Это может быть интересно :

- Постскриптум: пишем своего чат-бота

Могут ли у робота быть эмоции?

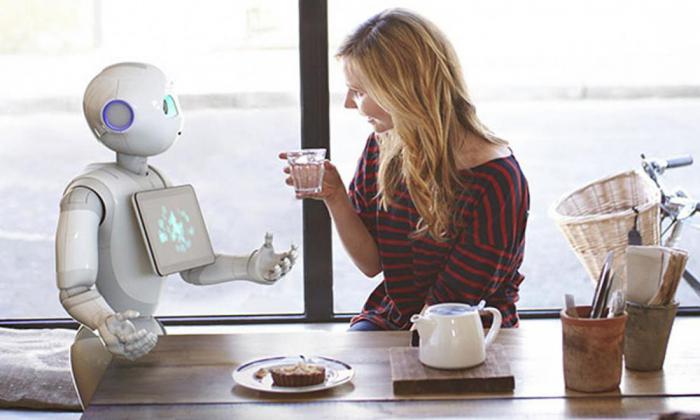

Уже в ближайшее время социальные роботы и роботы-помощники станут важной частью жизни людей. Они могут оказаться у вас дома, в больницах и в школах, они будут помогать с заботой о детях, о престарелых, будут ассистировать при реабилитации после болезни или травмы, а также в реализации любой другой формы помощи.

Каким должен быть робот?

Но как много человечество знает о психологии взаимодействия с роботами? Как должен выглядеть подобный робот? Как он должен передвигаться и реагировать на людей? На какую информацию он должен реагировать? Должен ли робот «проявлять» эмоции и отвечать на проявление эмоций человека? Насколько похожим на человека должен быть такой робот? Насколько инновационными могут быть научные идеи при разработке подобных роботов, способных быть отзывчивыми помощниками и оказывать необходимую и надежную поддержку, включая моменты особого стресса и напряжения, в которых может оказаться человек?

Научные исследования

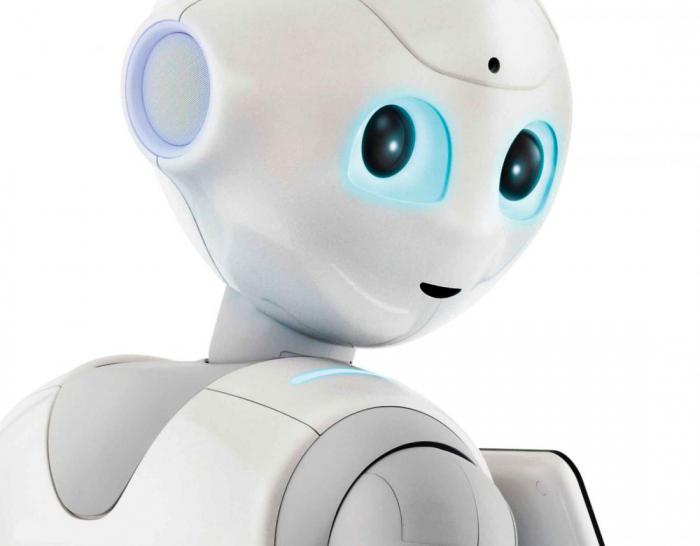

Пришло время взглянуть на два отдельных научных исследования, которые рассматривают то, как люди понимают эмоции у роботов и реагируют на них. В каждом наборе экспериментов очень детально изучались некоторые конкретные аспекты того, как роботы могут выглядеть или двигаться. Междисциплинарная международная команда ученых из Израиля и США занялась первым исследованием, второе же исследование было проведено в Америке при содействии экспертов из сфер роботехники, виртуальной реальности, человеческого фактора и человека как такового. Робот по имени Трэвис не выглядит как человек. Трэвис имеет небольшой размер, черты, отдаленно напоминающие какое-либо существо, большие уши, но при этом у него нет ни глаз, ни носа, ни рта. Его высота составляет около 28 сантиметров, и, когда вы ставите его на стол, голова Трэвиса оказывается примерно на уровне с лицом сидящего перед столом человека. Робот может кивать, раскачиваться или отворачиваться. У Трэвиса имеется часть, которую можно трактовать как вытянутую ногу, а также у него имеется вытянутая рука, в которой он держит смартфон, благодаря которому он работает.

Первый эксперимент

Когда участники (102 студента) прибыли в лабораторию, им было сказано, что они принимают участие в тестировании нового алгоритма понимания речи для роботов, и в рамках этого тестирования робот будет пытаться понять, что человек ему говорит. Участников попросили рассказать роботу о проблеме, заботе или стрессовой ситуации, с которой они столкнулись в недавнее время, например, о недавней ссоре с другом или членом семьи или о серьезной болезни. Их попросили также описать их проблему в трех частях, а также говорить, когда они заканчивают рассказывать каждую часть, после чего робот будет отвечать им с помощью смартфона. Однако участники не знали, что их случайным образом разделили на две группы. В «реагирующей» группе Трэвис находился лицом к участнику, когда тот рассказывал о своей проблеме, периодически слегка кивая головой и покачиваясь. Также в конце каждой из трех частей на экране смартфона демонстрировалось сообщение из готового набора, такое как «Я понимаю, через что ты проходишь» или «Тебе, наверное, пришлось нелегко». В действительности Трэвис даже не выбирал эти сообщения. Один из ученых слушал беседу и выбирал подходящее сообщение в нужное время.

Вторая группа

Участники «нереагирующей» группы столкнулись с совершенно другим Трэвисом. Он не кивал и не качался, а текст, который отображался на экране смартфона после завершения каждой из частей рассказа, просто сообщал участнику, чтобы он продолжал говорить. После завершения «беседы» участников попросили оценить робота по ряду критериев в форме ответов на несколько простых вопросов о том, насколько отзывчивым был Трэвис. Например, их просили по шкале от одного до десяти оценить, насколько они согласны с фразами «Робот понимал, что я думаю и чувствую» или «Робот действительно меня слышал». Другие вопросы также уточняли, насколько общительным и компетентным был Трэвис.

Каков же результат?

Также видеозаписи общения каждого из участников с Трэвисом были оценены независимыми судьями, которые не знали о том, в каких условиях находится каждый участник. Анализ беседы показал, что участники, которые общались с отзывчивым роботом, не рассказали больше о сути своей проблемы, чем участники, которые общались с неотзывчивым роботом. Однако отзывчивый Трэвис получил гораздо более высокую оценку по шкале общительности и компетентности (его описывали как способного, надежного и знающего). Что еще важнее, когда независимые судьи просматривали и оценивали видеозаписи, они заметили, что те участники, которые общались с отзывчивым Трэвисом, сами были гораздо более отзывчивыми по отношению к роботу и шли на открытый разговор. Они чаще наклонялись вперед к Трэвису, улыбались, поддерживали с ним зрительный контакт. Точно то же самое было обнаружено и в последующем исследовании, в рамках которого участников просили рассказать не отрицательное, а положительное событие в их жизни.

Выводы

Таким образом, даже когда робот не напоминает человека, люди быстро ухватывают даже самые слабые сигналы отзывчивости на их собственные слова и действия. Соответственно, дизайн робота не должен иметь большое количество различных деталей, жестов и вариантов действий, чтобы повысить человеческую оценку его отзывчивости и социальности. В результате можно сказать, что это открывает гораздо больше возможностей для того, чтобы разрабатывать функциональных роботов. Но что если человеку приходится столкнуться с роботом непосредственно тогда, когда он находится в состоянии стресса? Не когда он просто вспоминает что-то плохое, а переживает реальный физический и когнитивный стресс. Сможет ли стресс помешать человеку «прочитать» невербальную эмоциональную экспрессию робота?

Что насчет «чтения» эмоций в состоянии стресса?

И хотя исследования продемонстрировали, что люди способны читать эмоциональные выражения у роботов в повседневных нейтральных условиях, второе исследование, о котором пойдет речь, стало первым в истории, изучившим реакцию человека на робота непосредственно во время сильного стресса. В рамках исследования были симулированы стрессовые условия. Ученые заставляли участников погружать руку в ледяную воду на определенные промежутки времени, при этом подвергая их еще большему стрессу, заставляя решать сложные математические задания в уме. После этого их просили оценить эмоционально-экспрессивные или статически позы 60-сантиметрового робота-гуманоида Нао. Выражение лица и глаз Нао оставались неизменными, в то время как тело робота занимало одну из 25 различных поз, которые демонстрировали либо положительные, либо отрицательные эмоции.

Результаты второго исследования

Повлиял ли стресс на то, как участники могли «читать» позы робота? Второй группе участников повезло больше, они погружали руку в теплую воду и в уме выполняли простейшие арифметические примеры. Однако оказалось, что стресс оказывает крайне малое влияние на то, как люди воспринимают эмоции, за исключением тех поз, которые демонстрировали сильное оживление или возбуждение. Когда участники сами были подвержены стрессу, они воспринимали негативные позы робота как более негативные и менее оживленные или возбужденные. Другими словами, стресс немного сместил восприятие эмоций робота, поэтому негатив казался еще большим негативом, а позитив – меньшим позитивом.

Источник

Боты и люди: кто есть кто?

Чат-боты и способы их использования больше говорят не о машинном интеллекте, а о том, сколько неизведанного в людях.

Проблематика, связанная с искусственным интеллектом, глубже, чем анализ способностей компьютеров. Беседы с программами приближают нас к ответам на вопросы о главных загадках бытия. Несмотря на то, что ученые работают над коннектомом мозга человека, а компьютеры превратились из огромных вычислительных машин в смарт-утройства, некоторые вопросы, касающиеся высших психических функций, до сих пор не находят ответов. Объективность теста Тьюринга находится под вопросом, поскольку мы до сих пор не можем с уверенностью сказать, что же это такое — мышление.

Что на самом деле показывает тест Тьюринга?

Читайте также :

Ранее мы уже рассуждали о том, могут ли машины мыслить. В первую очередь в связи с этим вопросом вспоминают тест Тьюринга, суть которого состоит в том, что человеку, который общается посредством текста с компьютером и другим человеком, предлагается установить, кто есть кто. Программа при этом должна ввести собеседника в заблуждение, притворившись разумным существом. Идея теста появилась более 50 лет назад, и с тех пор компьютеры существенно продвинулись в развитии. Например, если в середине века для того, чтобы обработать запрос и ответить, машине требовалось больше времени, чем человеку, то теперь ботов, способных отвечать мгновенно, приходится учить выдерживать паузу для правдоподобия.

Ученый XIX века Теодор Липпс создал теорию вчувствования, согласно которой наши эмоциональные суждения распространяются на явления природы («радостный солнечный день», «тоскливый осенний дождь»), в то время как сама природа понятия не имеет, печальна она или радостна. Это может быть справедливо и для алгоритмов: мы стремимся увидеть в компьютере собеседника. Это отмечают исследователи, критикующие тест Тьюринга.

Можно сказать, что этот опыт не помогает установить подлинную сущность собеседника (машина или человек?), а показывает, соответствует ли тот нашим социальным ожиданиям и требованиям к диалогу.

Виртуальная романтика

Люди умудряются заводить с программами настоящие романы. Например, существуют сервисы fakegirlfriend.com и fakeinternetgirlfriend.com, создающие видимость, что человек, который ими пользуется, состоит в реальных отношениях. Проекты такой направленности соревнуются между собой в правдоподобии виртуального образа подруги, которая оставляет сообщения в социальных сетях, благодарит за подарки, публично признается в любви и поздравляет с праздниками. Сервисы Invisible Girlfriend и Invisible Boyfriend, которые обеспечивают максимальную персонализацию, позволяют обмениваться с вымышленным партнером сообщениями (правда, для этого потребуется американский или канадский телефонный номер).

В августе 2015-ого года разразился скандал, связанный с хакерским взломом и без того скандального «сайта для супружеских измен» Ashley Madison. В результате выяснилось, что практически все пользователи ресурса — мужчины, в то время как большая часть женщин — боты. Для того, чтобы отправлять сообщения, мужчинам нужно было платить деньги (таким образом, по утверждению руководителей проекта, формировалась платежеспособная аудитория). В результате пользователей ожидало общение с чат-ботами, которые генерировали сообщения вроде «привет, как дела».

Возможно, хорошая новость состоит в том, что количество реальных измен, которые совершились благодаря Ashley Madison, оказалось ничтожно малым. С другой стороны, внушительная часть аудитории сайта состояла из людей, готовых принять программу за человека и заплатить за это настоящими деньгами.

Мы убедились, что результат теста Тьюринга зависит от людских ожиданий. Это подтверждает история Ashley Madison. Люди легко попадают в ловушку и позволяют программам себя обмануть, если надеются на свидание: воображение достраивает картину приятного вечера, позволяя игнорировать несуразицу в сообщениях.

В отдельных случаях сбоев ПО боты начинали разговаривать друг с другом. Классик киберпанка Уильям Гибсон предположил в своем твиттере, что они готовят план бегства.

Самообразование неигровых персонажей

Среди геймдизайнеров в последнее время обсуждаются перспективы развития игр с открытым миром, в которых сюжет и образы персонажей не создаются разработчиком, а генерируются динамически, в соответствии с поведением игрока. Подвижки в этом направлении начались уже с выбора уровня сложности. Сейчас специальные программы могут регулировать атаки противников в зависимости от действий пользователя (например, Left for Dead), а элементы процедурной генерации используются для проработки среды. Однако настоящей «умной» виртуальной реальностью станет игра, способная обучаться у человека, развиваться и предлагать нестандартные решения. Благодаря этому неигровые персонажи смогут самостоятельно поддерживать осмысленные диалоги.

Джефф Оркин, разработчик игр и исследователь, защитил в Масачусетском технологическом институте диссертацию о краудсорсинге данных для разработки ИИ. Его концепция предполагает, что компьютер может анализировать поведение пользователя и самостоятельно выстраивать сюжеты, а персонаж будет приобретать квазиличность за счет естественно расширяющегося словаря и набора поведенческих реакций.

Читайте также :

Вместе с тем некоторые игроки бросают как многопользовательские, так и одиночные игры с необычным управлением или сложными правилами, потому что обучаться оказывается слишком трудно.

В онлайн-играх пользователи называют человеческий фактор одним из самых раздражающих багов. Никто не имеет гарантии, что другой человек вдруг не начнет убивать союзников, намеренно проигрывать бои или портить атмосферу.

Получается, что в чем-то homo ludens проигрывает по сравнению с machina ludens: в некоторых случаях программы оказываются лучшими игроками, чем люди.

Боты в интернете

В 2014 году исследовательская группа Сары Кесслер создала большое количество акканутов-ботов в Твиттере, чтобы выяснить, смогут ли фильтры сервиса и множество пользователей отличить «мёртвые души» от живых людей. Впрочем, как раз «мёртвыми» эти аккаунты не были. Они активно делали записи и перепосты, упоминали других блоггеров и набрали большое количество подписчиков.

Для распространения информации в интернете есть возможность создания целых ботоферм, которые будут размещать рекламу и политическую агитацию, либо намеренно «мусорить» в комментариях к неугодным хозяину «фермы» постам. Такие методы продвижения и создания информационного шума не вызывают уважения, однако часто находятся люди, которые начинают разговаривать с ботами или верить их текстам.

Иногда, натыкаясь на несвязные и безграмотные комментарии от других пользователей или получая бессмысленные сообщения, мы сомневаемся, писал ли это живой человек, либо примитивный бот. Так кто же все-таки должен проходить тест Тьюринга, робот или человек?

Боты и психоанализ

В 1960-х годах Джозеф Уайзенбаум создал знаменитую программу Элиза (ELIZA), которая имитировала поведение психотерапевта, задавая наводящие вопросы. Выяснилось, что чат-бот может быть быть идеальным аналитиком, реагируя на все реплики фразами вроде «Расскажите об этом», «Что вы чувствуете, говоря это?», «Почему это важно для вас?». Как идеальный психотерапевт, программа задает абстрактные вопросы и оставляет того, кто хочет выговориться, наедине с самим собой.

Это может быть интересно :

Иногда мы плохо понимаем других людей или отвечаем неадекватно. Мешают различие активных словарей, банальная невнимательность и желание поговорить «о своём» вырвав из контекста случайное слово в чужой речи. Получается, что в каждый момент, когда мы не понимаем другого и отвечаем на вопрос невпопад, мы ведем себя как плохо собранный виртуальный собеседник.

Проблема виртуального собеседника упирается в идею непознаваемости чужого мышления и малую изученность человеческого разума как такового. Создание машинного интеллекта — своего рода психоанализ для нашей цивилизации, способ ответить на вопросы о том, как мы размышляем и чего хотим от общения. Таким образом, моделирование мыслительных процессов и создание интеллектуальных программ является, в первую очередь, попыткой человека прояснить собственную сущность.

То, как удачно машина справляется с функцией аналитика, говорит о том, что в первую очередь мы ждем от диалога возможности выразить себя. На самом деле, программа перехватывает инициативу, избегая роли отвечающего, а заодно и логических сбоев.

Постскриптум: пишем своего чат-бота

Переходя от теории к практике, нужно сказать, что написание чат-бота — не только способ прояснить кое-что насчет искусственного интеллекта, а также своего словарного запаса и ассоциативных рядов, но и хорошее упражнение для программиста, которое дает мотивирующий интерактивный результат.

Чтобы научить чат-бота говорить, потребуется составить его словарь, разделив его на тематические блоки; на слово из соответствующего блока бот будет отзываться родственным словом. Можно сделать бота, который будет отвечать гиф-картинками и мемами, загружаемыми из интернета, по проставленным тэгам сопоставляя ситуации их использования со своим случаем.

В качестве туториала можно воспрользоваться онлайн-уроками. Например, на Курсотеке доступен курс Как создать своего чат-бота от автора чат-бота Eugene Goostman.

12 января 2016, 12:00

Мнение автора может не совпадать с позицией редакции.

Источник