- Emotion AI от Empath определяет эмоции по голосу

- Тест на эмпатию: как голосовые боты определяют пол и настроение людей

- Как голосовой софт распознает настроение человека

- В каких сферах ботам нужно уметь различать эмоции?

- Должен ли робот распознавать пол собеседника

- Введение в задачу распознавания эмоций

- Что такое эмоции?

- Классический подход к задаче классификации эмоций

- Классификация эмоций с применением deep learning

- Классификация эмоций по речи

- Аудиовизуальное распознавание эмоций

Emotion AI от Empath определяет эмоции по голосу

Определение эмоций человека по интонациям его голоса — уже относительно насыщенный рынок, на котором работают такие стартапы, как Affectiva, Beyond Verbal, Cogito и Realeyes, не говоря уже о том, что им интересуются и такие гиганты, как Amazon.

Потенциал у технологии большой — зная точное состояние человека можно изменить ответ умного помощника или человека в службе технической поддержки. Кроме того, понимание эмоция может помочь в мониторинге здоровья и обнаружении признаков некоторых заболевания, таких как, например, деменция или сердечная недостаточность.

Относительно новым участником в этом сегменте обнаружения эмоций является Empath, японский стартап, основанный в 2017 году. Он создал платформу, получившую название Emotion AI. ИИ компании способен автоматически определять одну из четырех эмоций — радость, гнев, спокойствие и печаль — в речи человека в режиме реального времени на любом языке в средах с высоким уровнем шума.

На основе Emotion AI уже работает система My Mood, позволяющая работникам отслеживать свое эмоциональное состояние и в целом определять его связь с погодой. А для разработчиков доступен Web Empath API, с помощью которого определение эмоций можно добавить в любое приложение или сервис.

До сих пор Web Empath AI преимущественно использовался в колл-центрах, где, по утверждению Empath, он сократил переработку менеджеров на 20%, а конверсию в продажи увеличил почти на 400%. Но в будущем, говорит стартап, его решения могут найти применение в видеоиграх, в роботах и даже в транспортных средствах. Недавно Empath заключил партнерское соглашение с компанией по производству игрушек Bocco, которая создала систему обмена сообщениями, предназначенную для детей, и с Utaka, которая делает лампу, подбирающую цвет под эмоции человека.

» data-medium-file=»https://i1.wp.com/apptractor.ru/wp-content/uploads/2019/09/1-1.jpg?fit=1024%2C1002&ssl=1″ data-large-file=»https://i1.wp.com/apptractor.ru/wp-content/uploads/2019/09/1-1.jpg?fit=740%2C724&ssl=1″ svg+xml,%3Csvg%20xmlns=’http://www.w3.org/2000/svg’%20viewBox=’0%200%20740%20724’%3E%3C/svg%3E» alt=»Emotion AI от Empath определяет эмоции по голосу» width=»740″ height=»724″ data-lazy-srcset=»https://i1.wp.com/apptractor.ru/wp-content/uploads/2019/09/1-1.jpg?w=1400&ssl=1 1400w, https://i1.wp.com/apptractor.ru/wp-content/uploads/2019/09/1-1.jpg?resize=640%2C626&ssl=1 640w, https://i1.wp.com/apptractor.ru/wp-content/uploads/2019/09/1-1.jpg?resize=1024%2C1002&ssl=1 1024w, https://i1.wp.com/apptractor.ru/wp-content/uploads/2019/09/1-1.jpg?resize=768%2C751&ssl=1 768w, https://i1.wp.com/apptractor.ru/wp-content/uploads/2019/09/1-1.jpg?resize=2048%2C2003&ssl=1 2048w» data-lazy-sizes=»(max-width: 740px) 100vw, 740px» data-recalc-dims=»1″ data-lazy-src=»https://i1.wp.com/apptractor.ru/wp-content/uploads/2019/09/1-1.jpg?resize=740%2C724&ssl=1″/>

The color changes in response to user emotions. (PRNewsFoto/Smartmedical Corp.)

Источник

Тест на эмпатию: как голосовые боты определяют пол и настроение людей

Голосовые ассистенты и умные колонки, которые некогда относились к разряду know-how, постепенно переходят в категорию обыденной реальности. По данным Statista, к концу этого года количество используемых продуктов на основе технологии достигнет 4,2 млрд в глобальных масштабах, а через четыре года этот показатель удвоится. Учитывая стремительную популяризацию голосовых интерфейсов, они станут более совершенными не только в распознавании речи, но и в других важных аспектов. Игорь Калинин, основатель компании TWIN, поделился последними достижениями рынка voice-роботов в сфере определения настроения и пола собеседника.

Читайте «Хайтек» в

Голосовые боты уже стали ценными сотрудниками, которые могут предоставить более качественный сервис за меньшую стоимость. Разумеется, в сравнении с человеком. Можно выделить несколько преимуществ ботов: они всегда на связи, мгновенно отвечают на звонок и сохраняют невозмутимость, даже если на том проводе не очень корректно и вежливо разговаривают. Но есть и очевидный минус: холодный рассудок бота не всегда нравится чересчур эмоциональному клиенту. Часто «машина» просто повторяет стандартный набор фраз, что только усиливает раздражение. Это приводит к необходимости создания эмоционального интеллекта.

Один из вариантов решения этой проблемы — предзаписанный скрипт для различных ситуаций, включая разговор с разъяренным собеседником. Он позволяет голосовому боту адаптироваться к ситуации и оказывать релевантную помощь. Это можно назвать запрограммированной эмпатией, главное условие которой — умение правильно распознавать эмоции человека и реагировать на них. И текущий уровень развития технологии существенно повышает EQ (с англ. Emotional Quotient, «эмоциональный интеллект» —«Хайтек») голосовых ботов. Например, боты TWIN в 96% случаев правильно определяют базовые эмоции: позитивные, негативные или нейтральные.

Но создание эмпатичных ботов, которые могут имитировать EQ благодаря предзаписанным сценариям, требует больших вычислительных мощностей, а значит, их стоимость автоматически возрастает. Для бизнеса это не всегда рентабельно. Именно поэтому зачастую робот переводит разговор на живого сотрудника, как только диалог требует эмпатического общения.

Как голосовой софт распознает настроение человека

Определение эмоций по голосу — это микросервис, постепенно обучающийся на примерах. Для этого собирают множество диалогов между ботом и клиентом и анализируют их качество, оценивая, насколько правильно робот распознал эмоцию. Ошибки корректируются и заменяются правильным вариантом в системе.

Однако без человека тут не обойтись. Анализом и маркировкой эмоций занимаются разметчики-лингвисты, четко определяющие оттенки речи и реакции: позитивной, негативной или базовой. Они прослушивают множество диалогов, из которых выделяют эпизоды с ярко выраженной эмоциональной окраской, категоризируют их и заносят в соответствующую базу. Так создается набор датасетов или моделей, составляющий основу эмоционального интеллекта бота. Очень важно, чтобы маркировкой занимался профессионал, так как даже небольшая погрешность может полностью «убить» весь датасет.

После того, как модель с размеченной выборкой данных готова, наступает фаза обучения нейронной сети. На этом этапе, помимо качества датасетов, нужны лучшие ML-инженеры (специалисты по машинному обучению — «Хайтек»). Кроме того, стоит тщательно подобрать стек технологий. Только так система будет идеально работать, распознавая эмоциональную окраску практически любой речи, за исключением шепота.

Главные сложности в распознавании эмоций:

- Многообразие эмоциональных оттенков — даже человеку бывает сложно отличить обеспокоенность и раздраженность. Именно поэтому пока разграничивают три базовые эмоции: это позволяет снизить погрешность.

- Форма выражения эмоций — часто в определении настроения робот опирается на словесные формулировки. Однако такой подход не всегда эффективен. Например, нецензурная лексика сама по себе не обязательно говорит о негативе. Поэтому в TWIN разделили два микросервиса определения эмоций: один обучен на голосе и используется в звонках, другой — на текстах, применяется в чатах.

В каких сферах ботам нужно уметь различать эмоции?

В сервисном сопровождении часто возникают ситуации, когда клиента нужно быстро перевести с робота на оператора, особенно если человек настроен негативно. Компании из транспортной отрасли часто сталкиваются с типичным обращением: в контакт-центр звонит разъяренный пользователь, не получивший вовремя заказ. Приняв звонок, робот слышит много критики в адрес компании, но не может адекватно отреагировать. Из подобных ситуаций мы вынесли урок: теперь звонок автоматически переводится на оператора, сразу как только система идентифицирует негативные эмоции.

Эмоциональный интеллект становится частью сервиса в электронной торговле. Так, например, Amazon научил своего голосового ассистента Alexa распознавать эмоции по интонации. Функция, вероятно, поможет улучшить качество коммуникации умного помощника и пользователей. А Emotibot предлагает голосового помощника для пост-продажного обслуживания в e-commerce. Бот подстраивает ответы под настроение собеседника, чтобы предотвратить эскалацию жалоб.

Call-центры тоже начинают экспериментировать с технологией распознавания эмоций для того, чтобы оценивать качество сервиса. Например, система может проанализировать речь оператора на предмет возникновения негативных оттенков речи: это контролирует коммуникацию сотрудников с клиентами и предупреждает регулярные нарушения этики общения.

Голосовые технологии с распознаванием эмоций помогают также анализировать динамику настроения клиентов: например, определять, стали ли покупатели в целом больше испытывать раздражение или, наоборот, обнаружили большую лояльность к бренду. Это дает понимание, проходит ли автоматизация call-центра успешно или какие-то процессы нуждаются в доработке. Так, например, подобную технологию протестировал Росбанк. В результате аналитики диалога бота и клиента менеджер получает статистический отчет по каждому звонку, где отражаются такие данные, как динамика индекса удовлетворенности потребителя и сравнительный индикатор эффективности сервиса.

Эмоциональное состояние напрямую влияет на готовность покупателя сделать покупку. Человеку проще что-то продать, когда он в хорошем настроении. Это подтверждают исследования: например, белорусский эксперимент продемонстрировал прямую связь между позитивными эмоциями и готовностью общаться с менеджером по продажам, а также общей лояльностью к бренду.

Распознавание эмоций может увеличить доход от ботов, которые занимаются обработкой лидов. Так, например, опираясь на этот маркер, робот-продавец способен сразу же переводить звонок на «живого» сотрудника, чтобы не упустить «горячий» лид. Вероятно, в будущем этот инструмент будут использовать большинство компании, где боты занимаются обзвоном холодной или теплой базы.

Индустрия разработки уже предложила онлайн-ритейлерам гайд-бота, который может выступить в роли цифрового консультанта и строить диалог с пользователем, исходя из его характера (бот определяет его по эмоциям). Однако подобные решения только вступили в стадию изучения и тестирования рынком, поэтому массового распространения пока не получили.

Должен ли робот распознавать пол собеседника

Клиенты хотят видеть индивидуальный подход к обслуживанию в любой индустрии. В ходе опроса SmarterHQ две трети потребителей признались: они вовлекаются в общение, только когда получают персонализированные сообщения. Это диктует необходимость и дальше работать над тем, чтобы голосовые боты становились умнее, сегментируя собеседников по различным критериям, из которых самое очевидное — это пол.

Распознавание пола позволяет строить речь с учетом этого критерия, а также снизить процент ошибок при наборе абонента. Например, если в базе значится Наталья, а трубку взял собеседник мужского пола, бот сможет моментально среагировать и произнести: «Могу я поговорить с Натальей?» вместо «Здравствуйте, Наталья».

Со звонками то же самое. Давайте смоделируем ситуацию: робот набирает клиента, чье имя в базе — Наталья. Соответственно, он переключается на режим общения с женщиной. Но вдруг трубку поднимает муж или брат Натальи и говорит: «Извините, я не Наталья». Если робот не определит по голосу пол собеседника, может получиться забавная ситуация: клиент будет доказывать, что он не Наталья, а робот будет продолжать общаться с Натальей, и разговор, скорее всего, очень быстро закончится.

Конечно, можно и вовсе отказаться от имен и обращаться ко всем унифицировано, ведь примерно в 3% случаев трубку берет человек, который не записан при регистрации. Но для ритейлеров, например, это будет стоит нескольких очков лояльности. Только представьте: вы заказали товар из интернет-магазина, перед его отправкой звонит бот и спрашивает, удобно ли будет получить заказ в ближайшее время. Безымянное обращение сделает разговор холодным, тогда как простое «Здравствуйте, Сергей!» сильно его смягчит. Очень кстати можно вспомнить крылатую фразу Дейла Карнеги: «Имя человека — самый сладостный и самый важный для него звук на любом языке». Это подтверждают и ученые Деннис П. Кармоди и Майкл Льюис, которые доказали, что наш мозг приходит в экстаз, когда мы слышим свое имя, что моментально концентрирует внимание на звуке.

Таким образом, чтобы избежать неловких ситуаций, при этом не жертвуя потребительской лояльностью, нужно отличать мужчин и женщин по голосу. Наши боты, например, правильно определяют пол человека в 98% случаев. На Западе аналогичной функцией оснащен My Voice AI, умеющий также определять примерный возраст и эмоциональное состояние.

Роботы только начинают изучать глубины человеческой речи и отличать настроение клиента или его пол. Вероятно, что в будущем технологии будут стремительно развиваться. По прогнозу Gartner, через два года «эмоциональной диагностикой» будут оснащены 10% всех устройств. Это неизбежно стимулирует развитие рынка систем для аналитики и распознавания эмоций: согласно данным MarketsAndMarkets, он вырастет с $21,6 млрд в 2019 году до $56 млрд к 2024 году при среднегодовом темпе прироста в 21%.

Источник

Введение в задачу распознавания эмоций

Распознавание эмоций – горячая тема в сфере искусственного интеллекта. К наиболее интересным областям применения подобных технологий можно отнести: распознавание состояния водителя, маркетинговые исследования, системы видеоаналитики для умных городов, человеко-машинное взаимодействие, мониторинг учащихся, проходящих online-курсы, носимые устройства и др.

В этом году компания ЦРТ посвятила этой теме свою летнюю школу по машинному обучению. В этой статье я постараюсь дать краткий экскурс в проблему распознавания эмоционального состояния человека и расскажу и подходах к ее решению.

Что такое эмоции?

Эмоция – это особый вид психических процессов, которые выражают переживание человеком его отношения к окружающему миру и самому себе. Согласно одной из теорий, автором которой является российский физиолог П.К. Анохин, способность испытывать эмоции была выработана в процессе эволюции как средство более успешной адаптации живых существ к условиям существования. Эмоция оказалась полезной для выживаемости и позволила живым существам быстро и наиболее экономно реагировать на внешние воздействия.

Эмоции играют огромную роль в жизни человека и межличностном общении. Они могут быть выражены различными способами: мимикой, позой, двигательными реакциями, голосом и вегетативными реакциями (частота сердечных сокращений, артериальное давление, частота дыхания). Однако наибольшей выразительностью обладает лицо человека.

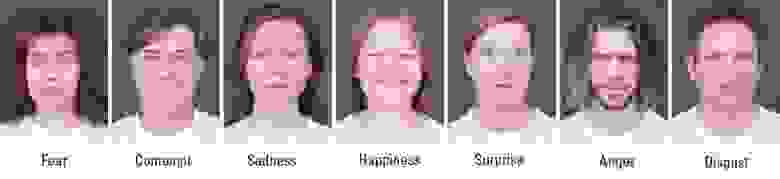

Каждый человек выражает эмоции несколько по-разному. Известный американский психолог Пол Экман, исследуя невербальное поведение изолированных племен в Папуа-Новой Гвинее в 70-х годах прошлого века, установил, что ряд эмоций, а именно: гнев, страх, печаль, отвращение, презрение, удивление и радость являются универсальными и могут быть поняты человеком, независимо от его культуры.

Люди способны выражать широкий спектр эмоций. Считается, что их можно описать как комбинацию базовых эмоций (например, ностальгия – это что-то среднее между печалью и радостью). Но такой категориальный подход не всегда удобен, т.к. не позволяет количественно охарактеризовать силу эмоции. Поэтому наряду с дискретными моделями эмоций, был разработан ряд непрерывных. В модели Дж. Рассела водится двумерный базис, в котором каждая эмоция характеризуется знаком (valence) и интенсивностью (arousal). Ввиду своей простоты модель Рассела в последнее время приобретает все большую популярность в контексте задачи автоматической классификации выражения лица.

Итак, мы выяснили, что если вы не пытаетесь скрыть эмоциональное возбуждение, то ваше текущее состояние можно оценить по мимике лица. Более того, используя современные достижения в области deep learning возможно даже построить детектор лжи, по мотивам сериала «Lie to me», научной основой которого послужили непосредственно работы Пола Экмана. Однако эта задача далеко не так проста. Как показали исследования нейробиолога Лизы Фельдман Барретт, при распознавании эмоций человек активно использует контекстную информацию: голос, действия, ситуацию. Взгляните на фотографии ниже, это действительно так. Используя только область лица, правильное предсказание сделать невозможно. В связи с этим для решения этой задачи необходимо использовать как дополнительные модальности, так и информацию об изменении сигналов с течением времени.

Здесь мы рассмотрим подходы к анализу только двух модальностей: аудио и видео, так как эти сигналы могут быть получены бесконтактным путем. Чтобы подступиться к задаче в первую очередь нужно раздобыть данные. Вот список наиболее крупных общедоступных баз эмоций, известных мне. Изображения и видео в этих базах были размечены вручную, некоторые с использованием Amazon Mechanical Turk.

| Название | Данные | Разметка | Год выпуска |

|---|---|---|---|

| OMG-Emotion challenge | aудио/видео | 7 категорий, valence/arousal | 2018 |

| EmotiW challenge | aудио/видео | 6 категорий | 2018 |

| AffectNet | изображения | 7 категорий, valence/arousal | 2017 |

| AFEW-VA | видео | valence/arousal | 2017 |

| EmotioNet challenge | изображения | 16 категорий | 2017 |

| EmoReact | aудио/видео | 17 категорий | 2016 |

Классический подход к задаче классификации эмоций

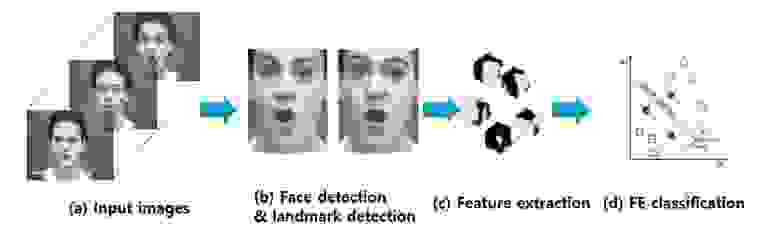

Наиболее простой способ определения эмоции по изображению лица основан на классификации ключевых точек (facial landmarks), координаты которых можно получить, используя различные алгоритмы PDM, CML, AAM, DPM или CNN. Обычно размечают от 5 до 68 точек, привязывая их к положению бровей, глаз, губ, носа, челюсти, что позволяет частично захватить мимику. Нормализованные координаты точек можно непосредственно подать в классификатор (например, SVM или Random Forest) и получить базовое решение. Естественно положение лиц при этом должно быть выровнено.

Простое использование координат без визуальной компоненты приводит к существенной потере полезной информации, поэтому для улучшения системы в этих точках вычисляют различные дескрипторы: LBP, HOG, SIFT, LATCH и др. После конкатенации дескрипторов и редукции размерности с помощью PCA полученный вектор признаков можно использовать для классификации эмоций.

Однако такой подход уже считается устаревшим, так как известно, что глубокие сверточные сети являются лучшим выбором для анализа визуальных данных.

Классификация эмоций с применением deep learning

Для того чтобы построить нейросетевой классификатор достаточно взять какую-нибудь сеть с базовой архитектурой, предварительно обученную на ImageNet, и переобучить последние несколько слоев. Так можно получить хорошее базовое решение для классификации различных данных, но учитывая специфику задачи, более подходящими будут нейросети, используемые для крупномасштабных задач распознавания лиц.

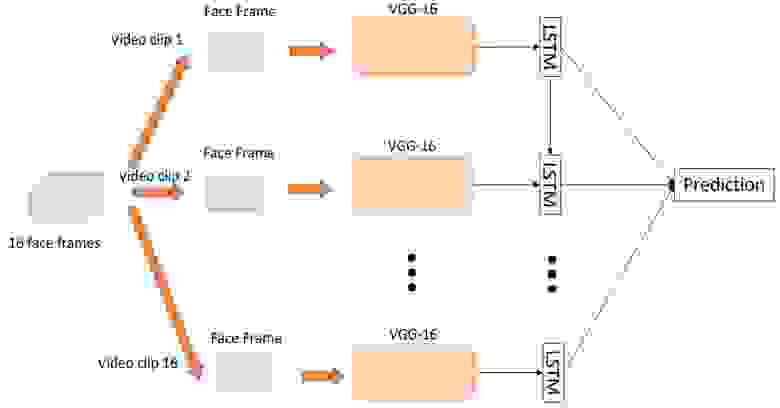

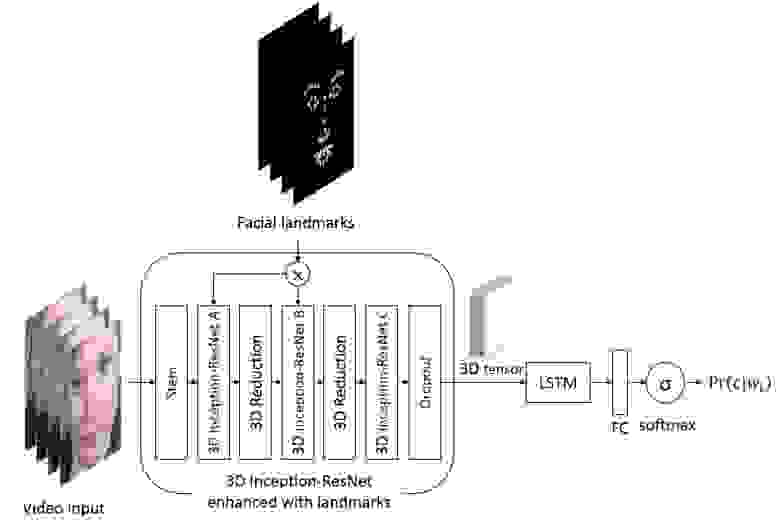

Итак, построить классификатор эмоций по отдельным изображениям достаточно просто, но как мы выяснили, мгновенные снимки не совсем точно отражают истинные эмоции, которые испытывает человек в данной ситуации. Поэтому для повышения точности системы необходимо анализировать последовательности кадров. Сделать это можно двумя путями. Первым способом является подача высокоуровневых признаков, полученных от CNN, классифицирующей каждый отдельный кадр, в рекуррентную сеть (например, LSTM) для захвата временной составляющей.

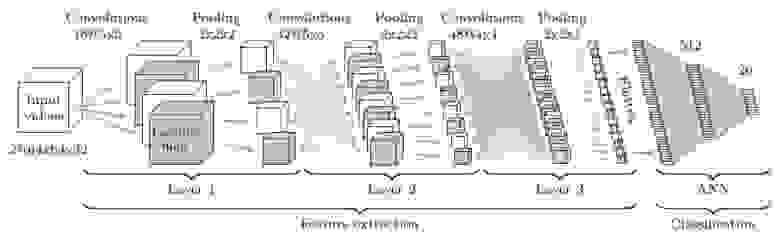

Второй способ заключается в непосредственной подаче последовательности кадров, взятых из видео с некоторым шагом, на вход 3D-CNN. Подобные CNN используют свертки с тремя степенями свободы, преобразующие четырехмерный вход в трехмерные карты признаков.

На самом деле в общем случае эти два подхода можно объединить, сконструировав вот такого монстра.

Классификация эмоций по речи

На основе визуальных данных можно с высокой точностью предсказывать знак эмоции, но при определении интенсивности предпочтительнее использовать речевые сигналы. Анализировать аудио немного сложнее ввиду сильной вариативности длительности речи и голосов дикторов. Обычно для этого используют не исходную звуковую волну, а разнообразные наборы признаков, например: F0, MFCC, LPC, i-вектора и др. В задаче распознавания эмоций по речи хорошо себя зарекомендовала открытая библиотека OpenSMILE, содержащая богатый набор алгоритмов для анализа речи и музыкальных сигналов. После извлечения, признаки могут быть поданы в SVM или LSTM для классификации.

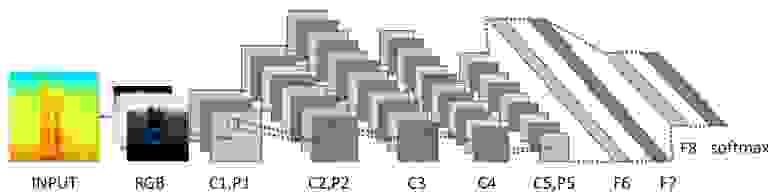

Однако в последнее время сверточные нейронные сети стали проникать и в область анализа звука, вытесняя устоявшиеся подходы. Для того чтобы их применить, звук представляют в виде спектрограмм в линейной или mel-шкале, после чего с полученными спектрограммами оперируют как с обычными двумерными изображениями. При этом проблема произвольного размера спектрограмм по временной оси элегантно решается при помощи статистического пулинга или за счет включения в архитектуру рекуррентной сети.

Аудиовизуальное распознавание эмоций

Итак, мы рассмотрели ряд подходов к анализу аудио- и видеомодальностей, остался заключительный этап – объединение классификаторов для вывода окончательного решения. Простейшим способом является непосредственное объединение их оценок. В этом случае достаточно взять максимум или среднее. Более сложным вариантом является объединение на уровне эмбеддингов для каждой модальности. Для этого часто применяют SVM, но это не всегда корректно, так как эмбеддинги могут иметь различную норму. В связи с этим были разработаны более продвинутые алгоритмы, например: Multiple Kernel Learning и ModDrop.

Ну и конечно стоит упомянуть о классе так называемых end-to-end решений, которые могут обучаться непосредственно на сырых данных от нескольких датчиков без всякой предварительной обработки.

В целом задача автоматического распознавания эмоций еще далека от решения. Судя по результатам прошлогоднего конкурса Emotion Recognition in the Wild, лучшие решения достигают точности порядка 60%. Надеюсь, что представленной в этой статье информации будет достаточно, для того чтобы попытаться построить собственную систему распознавания эмоций.

Источник