- УМНАЯ СТРАНА — территория умных людей и проектов

- Могут ли у роботов появиться эмоции?

- Научится ли искусственный интеллект испытывать какие-то чувства?

- Чем эмоции ИИ будут отличаться от эмоций людей

- Как мы переживаем эмоции?

- Можно ли научить ИИ испытывать что-то похожее?

- Ладно, как это сделать?

- И все-таки, хотя бы в теории такое возможно?

- Журнал | Социализация искусственного интеллекта: будут ли роботы чувствовать?

- – Расскажите, пожалуйста, о развитии эмоциональных технологий, эту область чаще называют «аффективные вычисления» (affective computing)?

- – А как выглядят эти технологии? Я представляю, как собирается база данных, допустим, по распознаванию лиц, а что насчет эмоций?

- – А какие сложности есть? Как, например, учитывается контекст проживания эмоций?

- – А социально-культурный аспект как-то учитывается? Я верно понимаю, что не везде та же улыбка означает радость…

- – Если у нас все же будет искусственный интеллект, способный к эмпатии, наделенный эмоциями, какой у него будет статус? Можно его будет приравнивать, допустим, к гражданину?

- – Можем обратиться к Уголовному кодексу: жестокое обращение с животными в целях причинения ему боли наказывается штрафом в размере до восьмидесяти тысяч рублей. То же деяние, совершенное с публичной демонстрацией, уже влечет штраф в размере от ста тысяч до трехсот тысяч рублей. Получается, общество наказывает не только за страдания существа, но и за пропаганду насилия.

- – Вероятно, будет расценено как пропаганда насилия, провокация…

УМНАЯ СТРАНА — территория умных людей и проектов

Могут ли у роботов появиться эмоции?

Научится ли искусственный интеллект испытывать какие-то чувства?

Современные роботы могут не просто говорить, двигаться, распознавать речь. Они научились понимать эмоции собеседника. Робот Гагарин, созданный в университете «Иннополис», считывает ощущения прямо с человеческого лица. Более того, он сам может имитировать удивление, радость, страх, отвращение, злость. Появятся ли в будущем роботы, способные переживать такие же эмоции, что и люди?

Искусственный интеллект в последние годы стремительно начал умнеть. Голосовые помощники «Google» и «Яндекса», беспилотные автомобили, роботы-андроиды, которые издалека вполне можно принять за человека. Ученые даже начали делать апокалиптические предсказания и сгущать краски вокруг будущего роботехники. Профессор Стивен Хокинг, к примеру, заявлял, что появление полноценного искусственного интеллекта будет началом конца. Роботы, сумевшие превзойти человека, долго смогут помогать выполнять ему разные задачи, но, в конце концов, выйдут из-под контроля.

Одним из шагов на пути к полноценному искусственному интеллекту некоторые ученые называют как раз возможность обретения им эмоций. При этом смайлики, эмотиконы, отправляемые роботами, не считаются. Речь идет о возможности роботов самим испытывать полноценные ощущения.

Робот как живое существо

Человеческие эмоции не что иное, как продукт эволюции. Они помогают как можно быстрее приспособиться и среагировать на внешние проявления. Эмоциями обладают не только люди, но и животные. Просто у людей переживания дополнены рациональным мышлением.

Искусственный интеллект на сегодня не может обладать эмоциями, так как он не живое существо. Однако в будущем все может измениться. Ученые уже сегодня называют наделение искусственного интеллекта эмоциями сложным и грандиозным проектом.

Робот с эмоциями человека должен обладать способностью к самообучению. Он должен не просто распознавать, но и понимать, анализировать эмоции человека. И лишь после этого он может научиться на эмоции отвечать эмоциями.

Эмоции помогли бы роботу более оперативно принимать какие-то решения. Без них же роботы остаются грудой металла, чипов и всевозможных алгоритмов. В реальности они оказываются нежизнеспособными.

Первые шаги по внедрению в искусственный интеллект эмоций человека уже начались. Исследователи из канадского университета Альберты удалось создать программу «Цефей». Она играла в течение месяца в покер, накапливая опыт. Робот достиг такого уровня, что перестал проигрывать вообще. Но главное, он показал жизнеспособность самообучающихся программ. Следующим шагом должно стать наделение подобных алгоритмов возможностью эмоционального реагирования и быстрого принятия решений на основе предыдущего опыта.

Шире распространены разработки, связанные с распознанием эмоционального состояния человека по лицу. Одним из первопроходцев была компания Mircrosoft. Она представила программу Project Oxford. Заложенный в программе искусственный интеллект мог по фотографии определить эмоциональное состояние человека. Делал он это на основе анализа микроэкспрессий лица.

Корпорация Apple двинулась дальше. Она приобрела стартап Emotient. Проект разработал робота, умеющего распознавать человеческие эмоции в реальном времени. Робот разлагает эмоциональное состояние человека на паттерны – «мимические шаблоны». На основе них программа определяет эмоциональное состояние человека.

В России подобные исследования тоже есть. К примеру, ученые из МИФИ создали умную нейросеть. Робот принимал участие в компьютерной игре, наравне с другими игроками. Никто из людей, игравших вместе с роботом, не смог отличить его от живых игроков.

Почти как «Терминатор»

Вопрос о том, можно ли после распознавания эмоций научить робота их ощущать, остается открыт. И ответа на него пока нет.

Эксперт в области высоких технологий Сергей Корогод заявил в комментарии порталу «Умная страна», что функция распознания эмоций у человека, которой наделяют искусственный интеллект, необходима для маркетинговых исследований.

«Искусственный интеллект научился понимать, как человек реагирует на ту или иную ситуацию. Это необходимо, чтобы учитывать предпочтения покупателей и продавать ему товары. Такие разработки будут финансироваться до тех пор, пока их можно использовать в политике и маркетинге, пока благодаря им можно контролировать пользователей», — сказал эксперт.

Он добавил, что сомневается, что роботы в будущем сами начнут испытывать эмоции. «Им, впрочем, это и не к чему, у них другие функции», — заключил Сергей Корогод.

Генеральный директор агентства по анализу данных Data Monsters Артемий Малков отметил, что если рассматривать эмоции как химическую реакцию или реакцию гормональную, реакцию организма на определенные вещества, то симулировать их вполне можно.

«Сегодня разработчики пытаются создавать не просто умных, но еще и социальных роботов. К примеру, мы работали в Бостоне с одним из проектов – «Джиба». Это был настольный робот, который умел не только разговаривать, но и крутиться. Он был похож на лампочку пиксара. Когда ему грустно, у него наклонялась голова, когда робот был радостный, он ерзал. Понятно, что искусственный интеллект сам не испытывал эмоций, а работал как алгоритм. Однако эмоциональная составляющая у роботов будет только усиливаться. Сегодня много разработок, связанных с распознаванием эмоций – их много в медицине, рекламе, клиентском обслуживании», — сказал эксперт.

Он добавил, что роботы могут управлять эмоциями людей уже сегодня.

«Роботы захватили мир. К примеру, «Facebook» является роботом, влияющим на жизнь людей. Из-за социальных сетей происходят революции и самоубийства. Небольшое изменение алгоритма может вызвать войну. Раньше думали, что в будущем как в фильме «Терминатор» роботы будут убивать людей. Но на самом деле, роботам достаточно просто научиться управлять человечеством», — заключил Артемий Малков.

Источник

Чем эмоции ИИ будут отличаться от эмоций людей

Как мы переживаем эмоции?

Об эксперте: Марина Чурикова, Lead Research Scientist в Neurodata Lab.

Эмоции — это комплексный психофизиологический ответ организма на события, происходящие в нашей жизни. Чтобы понять, можно ли научить нейросети эмоциям, вначале нужно разобраться с тем, что мы сами понимаем под эмоциями и как мы их переживаем.

Обычно переживание какой-либо эмоции включает в себя:

- некоторое внутреннее состояние, которое в обиходе и называется «эмоцией» (когда человеку грустно, страшно, или он испытывает радость);

- сопутствующие ему физиологические реакции (комплекс процессов, которые происходят в нервной, дыхательной, сердечно-сосудистой, и эндокринной системах организма);

- внешние проявления (изменения мимики, движений, жестов, интонации)

Можно ли научить ИИ испытывать что-то похожее?

Сможет ли нечто, не обладающее биологическим телом, когда-нибудь что-нибудь «испытывать» — сложный вопрос, на который мы пока не знаем ответа (хотя такой вариант довольно занимательно описан в рассказе Терри Биссона «Они сделаны из мяса» и фильме «Из машины»).

На данный момент мы можем научить ИИ лишь распознавать человеческие эмоции опосредованно через внешние проявления и реакции человеческого тела и демонстрировать (но не ощущать) сопереживание и эмпатию. Для того чтобы этого достичь, нужно последовательно пройти три этапа:

- нужно научить нейросеть распознавать эмоции собеседника-человека, чтобы сориентироваться в ситуации;

- затем научить ее синтезировать соответствующий ситуации ответ;

- научить ее выдавать этот ответ в форме правильной эмоциональной реакции.

Ладно, как это сделать?

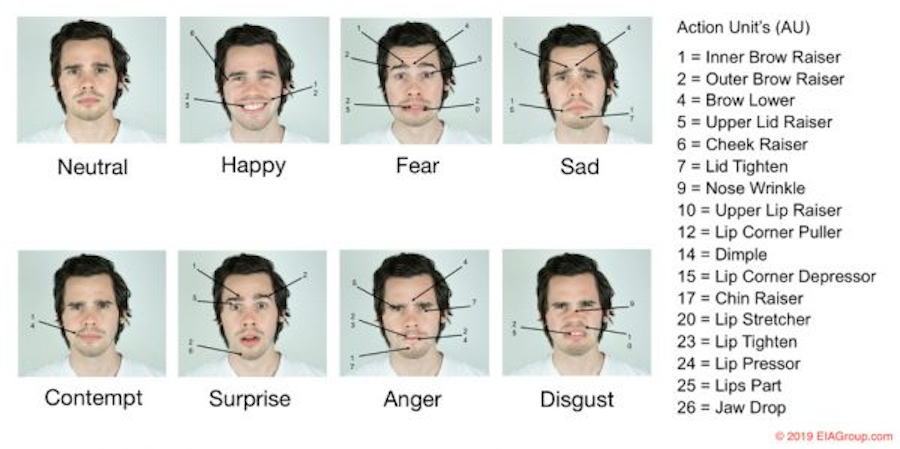

Первый этап — распознавание эмоций человека — ИИ уже неплохо освоил. Самые простые методы распознавания эмоций основаны на анализе взаимного расположения разных мимических сегментов лица. Сюда относится, например «система кодирования лицевых движений» (FACS) Пола Экмана, которая была положена в основу сериала «Обмани меня». Такая система может работать и без участия нейросетей: по сути, она выделяет ключевые точки на лице, затем по этим точкам распознает определенные области лица и их смещения.

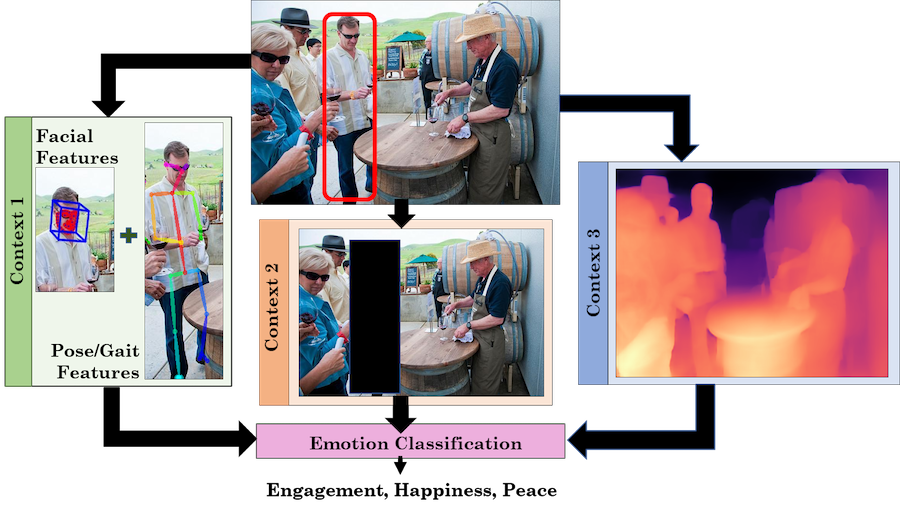

В современной науке подход Экмана признан устаревшим и подвергается критике, одна из причин которой — то, что его методика опирается на движения лицевых сегментов, которые далеко не всегда соответствуют определенной эмоции. Поскольку переживание эмоций может сопровождаться изменениями не только в мимике, но также в физиологии и поведении, то сейчас наиболее точным считается мультимодальное распознавание эмоций. Этот метод предлагает анализировать не расположение отдельных областей лица (например, поднялись брови вверх или сошлись у переносицы), а все лицо целиком на протяжении какого-то времени, ведь переживание любой эмоции имеет свою длительность и фазы. Кроме того, мультимодальный подход также включает анализ жестов, речи и интонации человека и его физиологических параметров.

Собрать все составляющие такой системы довольно сложно, но ученые достигли очень высокого уровня точности: например, сейчас мы располагаем алгоритмами, которые определяют частоту пульса и дыхания человека по видео, а ведь еще недавно это казалось фантастикой. Также на текущий момент мы уже можем неплохо распознавать интонацию, тембр и эмоциональную окрашенность голоса по аудиопотоку, что может использоваться, например, в разработке голосового помощника, где видеопоток недоступен.

Второй этап — синтез эмоционального ответа, то есть расчет того, какую реакцию ИИ должен выдать в ответ на какие-то человеческие эмоции. Синтез зависит не только от того, какую эмоцию ИИ распознал на первом этапе, но и от контекста происходящего — то есть, от ситуации, в которой находится человек, который взаимодействует с ИИ. Контекст играет важную роль в человеческом общении: мы воспринимаем всю ситуацию целиком, и сами интерпретируем эмоции собеседника не только в зависимости от выражения его лица, но и исходя из нашего жизненного опыта и того, как мы понимаем его состояние и слова. Например, если вы стоите в пробке, у вас текут слезы и вы задыхаетесь, то ИИ-помощник может интерпретировать выражение вашего лица и частоту дыхания как «грусть» и подготовить ответ, который должен вас утешить. На самом же деле у вас аллергия на пыльцу, вы забыли таблетки дома и ситуация приводит вас в ярость. Вам нужно не утешение, а адрес ближайшей аптеки, причем озвученный тоном, который не разозлит вас еще больше.

У нейросети «понимание» контекста может осуществляться через анализ окружающих предметов, собеседника, места и прочих доступных видимых параметров, но человеческим жизненным опытом ИИ не обладает. Для ИИ «опыт» — это все те данные, на которых он обучался, он ограничен ими и не может выйти за их пределы.

При синтезе эмоционального ответа нейросеть сможет выбрать его только из тех вариантов, которые ей показали при обучении. Люди же обладают уникальным жизненным опытом, который накапливают всю жизнь, отчего наши эмоции отличаются гибкостью и адаптацией к меняющемуся миру вокруг нас. Кроме того, огромная часть нашей коммуникации обусловлена обществом и культурой: мы проводим много времени на работе, в транспорте и общественных местах, где внешнее выражение эмоций ограничено определенными правилами поведения. Вдобавок наши эмоции могут быть спонтанными и во многом зависят от индивидуальных личностных черт, темперамента, особенностей нервной системы. Даже если представить, что ИИ сможет постоянно дообучаться, будет очень сложно записать и оцифровать все это многообразие реакций и контекстов. В данный момент сложно представить себе нейросетевой алгоритм, способный на такую гибкость.

Кроме того, есть и культурные особенности — например, у ряда культур существуют специальные понятия и знаковые системы для описания эмоций и состояний, которые отсутствуют в английском или русском языке. Это тоже добавляет сложности обучению эмпатичной нейросети.

И, наконец, третий этап — генерация ответа эмоциональным ИИ. Она должна быть достаточно точной и плавной, чтобы человек воспринимал это как естественный процесс и не ощущал, что общается с автоответчиком. Тогда алгоритму нужно воссоздать внешнее выражение эмоций — как минимум, сгенерировать эмоциональное лицо на изображении или видео с сопутствующими жестами и естественной интонацией ответа. Если же ИИ воплощен в механическом роботе, то, возможно, придется дополнительно поработать над пластичностью мимики его лица, плавными и естественными движениями конечностей и туловища (но не настолько, чтобы сделать его полностью антропоморфным, ведь такие объекты вызывают у нас дискомфорт). Вдобавок, вся эта реакция — лицо, мимика, движения и речь — должна генерироваться так же быстро, как это происходит в обычной беседе между людьми.

И все-таки, хотя бы в теории такое возможно?

Некоторые футурологи, например Рэй Курцвейл, считают, что искусственный интеллект будет развиваться по экспоненте, поскольку он создается на основе уже существующих технологий. И что, скорее всего, мы еще при жизни сможем застать появление по-настоящему сильного общего ИИ, способного, в том числе, осознавать себя и возможно даже испытывать эмоции. Однако его появление может создать неожиданную проблему: ИИ может не только достичь человеческого уровня интеллекта, но и сильно превзойти его за очень короткий срок. В результате мы как вид можем оказаться в положении, когда нам придется сосуществовать с чем-то, чьи расчеты, намерения, эмоции и мотивы будут слишком сложны для нашего понимания.

Произойдет ли все так, как предсказывает Курцвейл? Сможет ли ИИ в самом деле переживать эмоции? И будут ли они так уж отличаться от наших? Посмотрим.

Источник

Журнал | Социализация искусственного интеллекта: будут ли роботы чувствовать?

Можете ли вы испытывать эмоции к алгоритмам? Не торопитесь с ответом: вспомните, как вы злитесь на навигатор в автомобиле или шутите с Алисой и Siri. Возможно, совсем скоро они смогут отвечать вам взаимностью. О том, как технологии научились распознавать эмоции и какое место в будущем уготовано эмпатичным роботам, журналист Теплицы Юлия Каленкова поговорила с Дмитрием Люсиным, старшим научным сотрудником Института психологии РАН, кандидатом педагогических наук.

– Расскажите, пожалуйста, о развитии эмоциональных технологий, эту область чаще называют «аффективные вычисления» (affective computing)?

– Я предпочитаю использовать сам англоязычный термин affective computing. Наша задача – научиться, во-первых, автоматически распознавать человеческие эмоции, а во-вторых, имитировать их. Это позволит, например, создавать компьютерных агентов вроде Алисы или Siri, которые будут вести себя эмоционально. И уже потом можно будет наладить взаимодействие между этими виртуальными «людьми» – компьютерными агентами, и реальными. Цель – сделать это взаимодействие естественным, чтобы обе стороны реагировали на эмоции друг друга.

Стоит отметить, что эта идея витает в воздухе с 90-х годов, то есть это не та ситуация, когда создали искусственный интеллект, а затем вдруг решили «прикрепить» к нему социальные навыки или способность к распознаванию эмоций. Мы не просто берем искусственный интеллект и обучаем его, а именно изначально создаем системы, направленные именно на взаимодействие с человеком.

– А как выглядят эти технологии? Я представляю, как собирается база данных, допустим, по распознаванию лиц, а что насчет эмоций?

– Есть несколько подходов, и ни один из них не идеален. Проблема начинается уже с того, что даже люди по-разному понимают эмоции друг друга. Потому что мы получаем информацию об эмоциях из массы разных источников. Это мимика, жестикуляция, звучание голоса. Кроме эмоциональной экспрессии, имеет значение и смысл ситуации, в которой находится человек. Часто собранные из разных источников сведения противоречат друг другу. Таким образом, когда мы определяем эмоцию человека, весь вопрос в том, насколько точно можно угадать, что именно этот человек испытывает.

Кроме тех редких случаев, когда он однозначно обрадован или испуган, трудно определить конкретную реакцию. Порой ее не знает и сам человек. То есть в каком-то смысле мы конструируем эмоцию, и это уже, наверное, философский разговор.

И дальше все это переносится на affective computing. Изначально пытались делать по-простому, думали, что эмоция проявляется в экспрессии. И если мы правильно научим компьютер воспринимать и анализировать выражение лица, то он определит, какую эмоцию испытывает человек.

Такие попытки предпринимаются до сих пор, но без большого успеха – это всегда очень грубый результат. Но, в принципе, один из подходов в affective computing – анализировать выражение лица. Здесь мы имеем до некоторой степени априорные представления, какое выражение лица какой эмоции соответствует.

Современные технологии легко научились распознавать конфигурации лица. И если бы действительно каждая из конфигураций соответствовала определенной эмоции, задача была бы решена. Проблема в том, что нет прямого соотношения между конфигурациями лица и тем, какие эмоции человек испытывает.

Более продвинутый подход состоит не в том, чтобы просто анализировать лицо или звучание голоса, а в том, чтобы использовать машинное обучение. В этом случае мы собираем как можно больше информации о человеке. То есть мы берем видео, которое различает движение. Потом с помощью специальных программ по этому видео различаем движение лица, движение тела, звучание голоса и другие параметры. Видео дается аннотаторам – живым людям, которые определяют, какая эмоция в тот или иной момент переживается персонажем.

Нам нужен очень большой объем таких данных, и это отдельная сложная задача. И вот после того, как огромное количество видео оценило большое количество людей и определило, какие эмоции испытывают персонажи, мы «скармливаем» эту информацию нейросети. Она обучается распознавать эмоции не хуже самих аннотаторов.

За 21 год исследований Beyond Verbal Communications собрала данные о том, что от 35 до 40% эмоциональной информации содержится в вокальных интонациях. Продукт компании анализирует десятисекундные записи и извлекает из них данные об эмоциях, настроении, речевых привычках. Компания гордится базой в 2,3 млн образцов голоса на сорока языках мира. Стратегия проекта – на пересечении цифровой медицины и встраиваемых виртуальных ассистентов: определение эмоций по голосу снимает проблему множества слепых пятен, присущих классическим VPA (вроде Amazon Echo), ускоряя внедрение умных помощников.

Различные компании сейчас бьются над тем, чтобы создать большие дата-сеты (dataset, наборы данных), размеченные живыми людьми, аннотаторами. Остается только научить системы учиться, в частности, распознавать эмоции не хуже, чем живые люди. В целом это удается.

– А какие сложности есть? Как, например, учитывается контекст проживания эмоций?

– Возможный путь состоит в том, чтобы использовать не только информацию об экспрессиях, то есть о выражениях лица, движениях, звучании голоса, но и еще другую информацию – в том числе о ситуации, в которой находится человек. Когда распознают эмоции не автоматические системы, а мы, живые люди, учитывается не только эмоциональная экспрессия, но и логика ситуации.

Так, если человек находится в ситуации, где его кто-то обижает или дразнит, то каким бы ни было выражение лица и как бы ни звучал его голос, мы будем предполагать, что он испытывает что-то негативное, обижен или раздражен.

И если даже ничто не изменится в лице человека и его голос не дрогнет, мы предположим, что он скрывает свои отрицательные эмоции. Это и есть логика ситуации.

В идеале наши компьютерные системы должны уметь ее анализировать. Не просто ориентироваться на экспрессию, но и понимать контекст. К эмоциональной экспрессии мы пытаемся в affective computing добавлять анализ ситуации, анализ социальных взаимодействий, реакции других людей, помимо нашего основного персонажа. Это нам помогает более точно определить эмоцию, но процесс сложный и трудоемкий.

– А социально-культурный аспект как-то учитывается? Я верно понимаю, что не везде та же улыбка означает радость…

– Да, вы правы, и это одна из проблем в этой области. Действительно, эмоции в разных культурах и даже в разных социальных группах выражаются по-разному. То есть мы должны не просто брать аннотированные наборы данных, но и разделять их, учитывая разницу менталитета.

Тогда мы могли бы уже систему автоматического распознавания эмоций учить не просто каким-то усредненным образам, а именно культурному опыту. Не уверен, предпринимались ли такие попытки. Частично ситуацию спасает то, что обычно требуется определить эмоции определенных групп людей в определенных ситуациях. Этого достаточно для решения прикладных задач.

Например, нас интересует удовлетворенность обслуживанием клиентов банка, и мы хотим определить ее по выражениям лица или другим экспрессивным признакам. Берем dataset, состоящий из клиентов этого банка, которые приходят именно в этот банк для получения услуг. Тогда наш набор людей, «носителей» эмоции, наш культурный и социальный контексты достаточно жестко фиксируются. И тогда уже проще научить систему распознавать эмоции.

Но эмоции всех людей на Земле и в любых контекстах действительно распознавать проблематично. Мне пока неизвестно, чтобы это делалось. Каждый из нас ограничен той культурой, теми представлениями, которые у нас есть. И поэтому когда мы видим проявление эмоций у людей из другой культуры, мы легко можем ошибиться. Самые очевидные вещи мы, конечно, воспримем правильно, но тонкости – нет. Этим ограничены и искусственные системы.

– Если у нас все же будет искусственный интеллект, способный к эмпатии, наделенный эмоциями, какой у него будет статус? Можно его будет приравнивать, допустим, к гражданину?

– Если коротко, я не знаю. Такими вопросами должны заниматься специалисты по этике. Казалось бы, так как это искусственный интеллект, который не испытывает эмоции, а просто имитирует их, то и проблемы нет.

Можно привести аналогию с куклой. Если в ответ на голос хозяина она начинает плакать или улыбаться, мы понимаем, что это всего лишь движения механизма. Имеет ли смысл говорить о защите прав этой куклы?

Но есть другой аспект – как человек относится к этому роботу или искусственному существу. Уже минимум 20 лет в психологии изучают отношение людей к искусственным агентам.

У нас легко возникает эмпатия по отношению к ним. При этом роботы совершенно не обязаны быть даже человекоподобными. Некоторые шутят с Алисой или ругаются с навигатором в автомобиле. И встает вопрос: что делать потом с этими роботами, когда они выходят из строя? Какие этические проблемы связаны с самими роботами, а какие – с людьми, которые взаимодействуют с роботами? Если человек ведет себя жестоко по отношению к роботу: ломает, бьет его, как к этому относиться?

Если ребенок проявляет жестокость по отношению к кукле или взрослый по отношению к роботу, то, возможно, у них есть психологические проблемы, которые потом будут переноситься на живых людей.

И еще: допустим, человек жестоко относится к животным и получает наказание. Это санкция за то, что он доставил страдания живому существу или за нарушение общих правил поведения?

– Можем обратиться к Уголовному кодексу: жестокое обращение с животными в целях причинения ему боли наказывается штрафом в размере до восьмидесяти тысяч рублей. То же деяние, совершенное с публичной демонстрацией, уже влечет штраф в размере от ста тысяч до трехсот тысяч рублей. Получается, общество наказывает не только за страдания существа, но и за пропаганду насилия.

– Это интересный аспект. Таким образом, возможно, в будущем будут наказывать за жестокое обращение с роботами не потому что тем больно или обидно, а потому что это нарушает какие-то представления о человеческом поведении.

Но правильно ли это? Вообще, существует этическая максима (правило поведения, которое можно принять как хорошее руководство к действию. – Прим. ред.): человек имеет право делать все до тех пор, пока это не наносит вреда другим. И если человек, допустим, не издевается над кошкой, а лишь делает вид – он несет за это ответственность?

– Вероятно, будет расценено как пропаганда насилия, провокация…

– Есть такое ощущение, что это что-то, что на самом деле некоторым людям хотелось бы делать, но нравственные и общественные нормы не позволяют. И тогда, видимо, если будут санкции за жестокое обращение с роботами, то суть будет не в том, что роботам больно. А в том, что если можно по отношению к роботам себя так вести, то, возможно, люди потом будут вести себя так же плохо по отношению к живым существам.

Однако эта логика небезупречная. Может быть, вымещая свою агрессию на роботах, человек потом не будет срываться на других людях. В любом случае мы не можем отдать на откуп роботу решение этических вопросов, с ними нам придется разбираться самостоятельно.

Источник