- Могут ли у робота быть эмоции?

- Каким должен быть робот?

- Научные исследования

- Первый эксперимент

- Вторая группа

- Каков же результат?

- Выводы

- Что насчет «чтения» эмоций в состоянии стресса?

- Результаты второго исследования

- УМНАЯ СТРАНА — территория умных людей и проектов

- Могут ли у роботов появиться эмоции?

- Научится ли искусственный интеллект испытывать какие-то чувства?

- Смогут ли роботы почувствовать собственное «я»?

- Физическое «я»

- Полное «я»

Могут ли у робота быть эмоции?

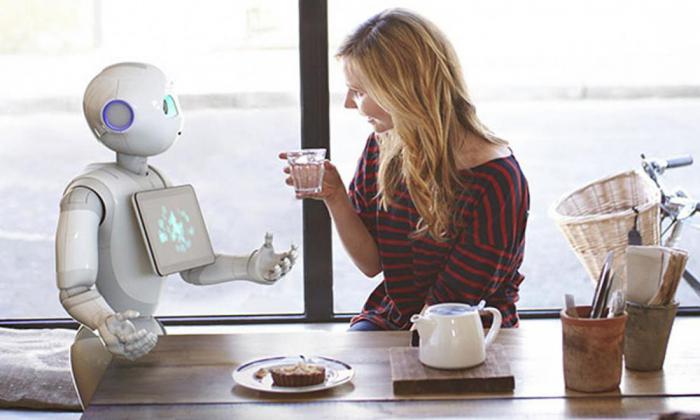

Уже в ближайшее время социальные роботы и роботы-помощники станут важной частью жизни людей. Они могут оказаться у вас дома, в больницах и в школах, они будут помогать с заботой о детях, о престарелых, будут ассистировать при реабилитации после болезни или травмы, а также в реализации любой другой формы помощи.

Каким должен быть робот?

Но как много человечество знает о психологии взаимодействия с роботами? Как должен выглядеть подобный робот? Как он должен передвигаться и реагировать на людей? На какую информацию он должен реагировать? Должен ли робот «проявлять» эмоции и отвечать на проявление эмоций человека? Насколько похожим на человека должен быть такой робот? Насколько инновационными могут быть научные идеи при разработке подобных роботов, способных быть отзывчивыми помощниками и оказывать необходимую и надежную поддержку, включая моменты особого стресса и напряжения, в которых может оказаться человек?

Научные исследования

Пришло время взглянуть на два отдельных научных исследования, которые рассматривают то, как люди понимают эмоции у роботов и реагируют на них. В каждом наборе экспериментов очень детально изучались некоторые конкретные аспекты того, как роботы могут выглядеть или двигаться. Междисциплинарная международная команда ученых из Израиля и США занялась первым исследованием, второе же исследование было проведено в Америке при содействии экспертов из сфер роботехники, виртуальной реальности, человеческого фактора и человека как такового. Робот по имени Трэвис не выглядит как человек. Трэвис имеет небольшой размер, черты, отдаленно напоминающие какое-либо существо, большие уши, но при этом у него нет ни глаз, ни носа, ни рта. Его высота составляет около 28 сантиметров, и, когда вы ставите его на стол, голова Трэвиса оказывается примерно на уровне с лицом сидящего перед столом человека. Робот может кивать, раскачиваться или отворачиваться. У Трэвиса имеется часть, которую можно трактовать как вытянутую ногу, а также у него имеется вытянутая рука, в которой он держит смартфон, благодаря которому он работает.

Первый эксперимент

Когда участники (102 студента) прибыли в лабораторию, им было сказано, что они принимают участие в тестировании нового алгоритма понимания речи для роботов, и в рамках этого тестирования робот будет пытаться понять, что человек ему говорит. Участников попросили рассказать роботу о проблеме, заботе или стрессовой ситуации, с которой они столкнулись в недавнее время, например, о недавней ссоре с другом или членом семьи или о серьезной болезни. Их попросили также описать их проблему в трех частях, а также говорить, когда они заканчивают рассказывать каждую часть, после чего робот будет отвечать им с помощью смартфона. Однако участники не знали, что их случайным образом разделили на две группы. В «реагирующей» группе Трэвис находился лицом к участнику, когда тот рассказывал о своей проблеме, периодически слегка кивая головой и покачиваясь. Также в конце каждой из трех частей на экране смартфона демонстрировалось сообщение из готового набора, такое как «Я понимаю, через что ты проходишь» или «Тебе, наверное, пришлось нелегко». В действительности Трэвис даже не выбирал эти сообщения. Один из ученых слушал беседу и выбирал подходящее сообщение в нужное время.

Вторая группа

Участники «нереагирующей» группы столкнулись с совершенно другим Трэвисом. Он не кивал и не качался, а текст, который отображался на экране смартфона после завершения каждой из частей рассказа, просто сообщал участнику, чтобы он продолжал говорить. После завершения «беседы» участников попросили оценить робота по ряду критериев в форме ответов на несколько простых вопросов о том, насколько отзывчивым был Трэвис. Например, их просили по шкале от одного до десяти оценить, насколько они согласны с фразами «Робот понимал, что я думаю и чувствую» или «Робот действительно меня слышал». Другие вопросы также уточняли, насколько общительным и компетентным был Трэвис.

Каков же результат?

Также видеозаписи общения каждого из участников с Трэвисом были оценены независимыми судьями, которые не знали о том, в каких условиях находится каждый участник. Анализ беседы показал, что участники, которые общались с отзывчивым роботом, не рассказали больше о сути своей проблемы, чем участники, которые общались с неотзывчивым роботом. Однако отзывчивый Трэвис получил гораздо более высокую оценку по шкале общительности и компетентности (его описывали как способного, надежного и знающего). Что еще важнее, когда независимые судьи просматривали и оценивали видеозаписи, они заметили, что те участники, которые общались с отзывчивым Трэвисом, сами были гораздо более отзывчивыми по отношению к роботу и шли на открытый разговор. Они чаще наклонялись вперед к Трэвису, улыбались, поддерживали с ним зрительный контакт. Точно то же самое было обнаружено и в последующем исследовании, в рамках которого участников просили рассказать не отрицательное, а положительное событие в их жизни.

Выводы

Таким образом, даже когда робот не напоминает человека, люди быстро ухватывают даже самые слабые сигналы отзывчивости на их собственные слова и действия. Соответственно, дизайн робота не должен иметь большое количество различных деталей, жестов и вариантов действий, чтобы повысить человеческую оценку его отзывчивости и социальности. В результате можно сказать, что это открывает гораздо больше возможностей для того, чтобы разрабатывать функциональных роботов. Но что если человеку приходится столкнуться с роботом непосредственно тогда, когда он находится в состоянии стресса? Не когда он просто вспоминает что-то плохое, а переживает реальный физический и когнитивный стресс. Сможет ли стресс помешать человеку «прочитать» невербальную эмоциональную экспрессию робота?

Что насчет «чтения» эмоций в состоянии стресса?

И хотя исследования продемонстрировали, что люди способны читать эмоциональные выражения у роботов в повседневных нейтральных условиях, второе исследование, о котором пойдет речь, стало первым в истории, изучившим реакцию человека на робота непосредственно во время сильного стресса. В рамках исследования были симулированы стрессовые условия. Ученые заставляли участников погружать руку в ледяную воду на определенные промежутки времени, при этом подвергая их еще большему стрессу, заставляя решать сложные математические задания в уме. После этого их просили оценить эмоционально-экспрессивные или статически позы 60-сантиметрового робота-гуманоида Нао. Выражение лица и глаз Нао оставались неизменными, в то время как тело робота занимало одну из 25 различных поз, которые демонстрировали либо положительные, либо отрицательные эмоции.

Результаты второго исследования

Повлиял ли стресс на то, как участники могли «читать» позы робота? Второй группе участников повезло больше, они погружали руку в теплую воду и в уме выполняли простейшие арифметические примеры. Однако оказалось, что стресс оказывает крайне малое влияние на то, как люди воспринимают эмоции, за исключением тех поз, которые демонстрировали сильное оживление или возбуждение. Когда участники сами были подвержены стрессу, они воспринимали негативные позы робота как более негативные и менее оживленные или возбужденные. Другими словами, стресс немного сместил восприятие эмоций робота, поэтому негатив казался еще большим негативом, а позитив – меньшим позитивом.

Источник

УМНАЯ СТРАНА — территория умных людей и проектов

Могут ли у роботов появиться эмоции?

Научится ли искусственный интеллект испытывать какие-то чувства?

Современные роботы могут не просто говорить, двигаться, распознавать речь. Они научились понимать эмоции собеседника. Робот Гагарин, созданный в университете «Иннополис», считывает ощущения прямо с человеческого лица. Более того, он сам может имитировать удивление, радость, страх, отвращение, злость. Появятся ли в будущем роботы, способные переживать такие же эмоции, что и люди?

Искусственный интеллект в последние годы стремительно начал умнеть. Голосовые помощники «Google» и «Яндекса», беспилотные автомобили, роботы-андроиды, которые издалека вполне можно принять за человека. Ученые даже начали делать апокалиптические предсказания и сгущать краски вокруг будущего роботехники. Профессор Стивен Хокинг, к примеру, заявлял, что появление полноценного искусственного интеллекта будет началом конца. Роботы, сумевшие превзойти человека, долго смогут помогать выполнять ему разные задачи, но, в конце концов, выйдут из-под контроля.

Одним из шагов на пути к полноценному искусственному интеллекту некоторые ученые называют как раз возможность обретения им эмоций. При этом смайлики, эмотиконы, отправляемые роботами, не считаются. Речь идет о возможности роботов самим испытывать полноценные ощущения.

Робот как живое существо

Человеческие эмоции не что иное, как продукт эволюции. Они помогают как можно быстрее приспособиться и среагировать на внешние проявления. Эмоциями обладают не только люди, но и животные. Просто у людей переживания дополнены рациональным мышлением.

Искусственный интеллект на сегодня не может обладать эмоциями, так как он не живое существо. Однако в будущем все может измениться. Ученые уже сегодня называют наделение искусственного интеллекта эмоциями сложным и грандиозным проектом.

Робот с эмоциями человека должен обладать способностью к самообучению. Он должен не просто распознавать, но и понимать, анализировать эмоции человека. И лишь после этого он может научиться на эмоции отвечать эмоциями.

Эмоции помогли бы роботу более оперативно принимать какие-то решения. Без них же роботы остаются грудой металла, чипов и всевозможных алгоритмов. В реальности они оказываются нежизнеспособными.

Первые шаги по внедрению в искусственный интеллект эмоций человека уже начались. Исследователи из канадского университета Альберты удалось создать программу «Цефей». Она играла в течение месяца в покер, накапливая опыт. Робот достиг такого уровня, что перестал проигрывать вообще. Но главное, он показал жизнеспособность самообучающихся программ. Следующим шагом должно стать наделение подобных алгоритмов возможностью эмоционального реагирования и быстрого принятия решений на основе предыдущего опыта.

Шире распространены разработки, связанные с распознанием эмоционального состояния человека по лицу. Одним из первопроходцев была компания Mircrosoft. Она представила программу Project Oxford. Заложенный в программе искусственный интеллект мог по фотографии определить эмоциональное состояние человека. Делал он это на основе анализа микроэкспрессий лица.

Корпорация Apple двинулась дальше. Она приобрела стартап Emotient. Проект разработал робота, умеющего распознавать человеческие эмоции в реальном времени. Робот разлагает эмоциональное состояние человека на паттерны – «мимические шаблоны». На основе них программа определяет эмоциональное состояние человека.

В России подобные исследования тоже есть. К примеру, ученые из МИФИ создали умную нейросеть. Робот принимал участие в компьютерной игре, наравне с другими игроками. Никто из людей, игравших вместе с роботом, не смог отличить его от живых игроков.

Почти как «Терминатор»

Вопрос о том, можно ли после распознавания эмоций научить робота их ощущать, остается открыт. И ответа на него пока нет.

Эксперт в области высоких технологий Сергей Корогод заявил в комментарии порталу «Умная страна», что функция распознания эмоций у человека, которой наделяют искусственный интеллект, необходима для маркетинговых исследований.

«Искусственный интеллект научился понимать, как человек реагирует на ту или иную ситуацию. Это необходимо, чтобы учитывать предпочтения покупателей и продавать ему товары. Такие разработки будут финансироваться до тех пор, пока их можно использовать в политике и маркетинге, пока благодаря им можно контролировать пользователей», — сказал эксперт.

Он добавил, что сомневается, что роботы в будущем сами начнут испытывать эмоции. «Им, впрочем, это и не к чему, у них другие функции», — заключил Сергей Корогод.

Генеральный директор агентства по анализу данных Data Monsters Артемий Малков отметил, что если рассматривать эмоции как химическую реакцию или реакцию гормональную, реакцию организма на определенные вещества, то симулировать их вполне можно.

«Сегодня разработчики пытаются создавать не просто умных, но еще и социальных роботов. К примеру, мы работали в Бостоне с одним из проектов – «Джиба». Это был настольный робот, который умел не только разговаривать, но и крутиться. Он был похож на лампочку пиксара. Когда ему грустно, у него наклонялась голова, когда робот был радостный, он ерзал. Понятно, что искусственный интеллект сам не испытывал эмоций, а работал как алгоритм. Однако эмоциональная составляющая у роботов будет только усиливаться. Сегодня много разработок, связанных с распознаванием эмоций – их много в медицине, рекламе, клиентском обслуживании», — сказал эксперт.

Он добавил, что роботы могут управлять эмоциями людей уже сегодня.

«Роботы захватили мир. К примеру, «Facebook» является роботом, влияющим на жизнь людей. Из-за социальных сетей происходят революции и самоубийства. Небольшое изменение алгоритма может вызвать войну. Раньше думали, что в будущем как в фильме «Терминатор» роботы будут убивать людей. Но на самом деле, роботам достаточно просто научиться управлять человечеством», — заключил Артемий Малков.

Источник

Смогут ли роботы почувствовать собственное «я»?

28 февраля 2019

Человеческая природа основывается на чувстве собственного «я». Без этого мы не могли бы ориентироваться, взаимодействовать, проявлять чувства и выживать в постоянно меняющемся, сложном мире людей. Чувство самоощущения нужно не только когда мы совершаем определенные действия, но и когда мы предполагаем последствия этих действий для себя и других.

Поскольку рано или поздно роботов планируют впустить в наш социальный мир, формирование чувства самоощущения в ИскИнах является одной из главных задач для ученых. Если машинам все-таки суждено заботиться о нас и стать нашими компаньонами, то они должны быть способны поставить себя на наше место. И хотя ученым еще очень далеко до создания робота, так же как человек, обладающего чувством собственного «я», шаг за шагом они приближаются к этой цели.

Авторы нового исследования, опубликованного в Science Robotics, разработали роботизированную руку, имеющую представление о своей физической форме – один из основных принципов самоощущения. Это очень важный шаг в развитии отрасли.

Точного научного объяснения чувства человеческого «я» не существует. Последние исследования в области нейробиологии демонстрируют, что кортикальные сети в двигательной и теменной частях мозга часто активируются в ситуациях, когда мы не совершаем физических движений. Например, при словах «укол или пинок» активируются двигательные зоны мозга. То же самое происходит, когда мы наблюдаем за движущимся человеком.

Выведенная в результате этих наблюдений гипотеза состоит в том, что мы понимаем других так, как будто действуем сами – явление, которое ученые называют «воплощенной симуляцией». Другими словами, мы используем свою возможность задействовать телесные ресурсы для того, чтобы придать значение действиям или целям других людей. Механизм, лежащий в основе этого процесса симуляции, представляет собой ментальную модель тела или самого себя. И именно это ученые пытаются воспроизвести в машинах.

Физическое «я»

Для создания модели самоощущения в роботизированной руке команда ученых использовала сеть глубокого обучения и данные случайных движений. Очень важно то, что устройству ИИ не сообщалось какой-либо информации о его геометрической форме или основополагающих физических процессах – все это робот узнавал постепенно, в процессе движения и взаимодействия с различными предметами, точно так же, как познает себя ребенок.

В дальнейшем машина сможет использовать эту модель самоощущения, содержащую информацию о ее форме, размере и движениях, для прогнозирования будущих состояний действий, например, она сможет взять что-то с помощью инструмента. Когда ученые внесли в роботизированную руку физические изменения, противоречия между прогнозами робота и реальностью заставили исследователей начать учебный процесс заново, чтобы позволить роботу адаптировать модель своего «я» под новую форму тела.

Хотя в описываемом исследовании использовалась одна рука, подобные модели были разработаны и для человекоподобных роботов.

Полное «я»

Тем не менее, такое самоощущение робота очень далеко от человеческого. Подобно луковице, наше восприятие самих себя имеет несколько слоев, включающих способность идентифицировать свое тело, находясь внутри его физических границ и воспринимая мир со зрительно-пространственной перспективы этого тела. Однако в это ощущение также входят процессы, выходящие за внешние рамки, такие как интеграция сенсорной информации и представление во времени, получаемые через память, самоидентификацию, а также принадлежность и конфиденциальность действий (люди не могут читать чужих мыслей).

Хотя задача создания чувства самоощущения во всех этих слоях у робота все еще очень далека от завершения, ее отдельные компоненты, такие как схема, продемонстрированная в описываемом исследовании, уже формируются. Можно создать машины, имитирующие других людей и прогнозирующие их намерения или адаптирующие их восприятие. Такие разработки наряду с развитием эпизодической памяти также являются важными шагами на пути к созданию социально осознающих себя роботов-компаньонов.

Любопытно, что данное исследование также может оказаться полезным в исследовании самоощущения человека. Теперь нам известно, что роботы могут приспосабливать физическую модель своего «я» к изменениям, производимым в их теле. Альтернативный способ подумать об этом – представить процесс в контексте использования инструментов животными, когда их тело соприкасается с различными внешними предметами (палки, вилки, мечи или смартфоны).

Результаты исследований демонстрируют, что во время хватания предметов рукой и щипцами у обезьяны активизируются одни и те же нейроны, то есть обученная пользоваться щипцами обезьяна воспринимает их как свои пальцы. Инструмент становится частью тела и физическое самоощущение изменяется. Это похоже на то, как мы ассоциируем себя с аватаром на экране компьютера, играя в видеоигры.

Интересная идея, впервые предложенная японским нейробиологом Ацуши Ирики (Atsushi Iriki), состоит в том, что способность объединения внешних объектов с телом и способность восприятия других тел в качестве инструментов являются двумя сторонами одной медали. Примечательно, что это смутное различие требует появления виртуальной концепции – себя – действующей в качестве символа-заменителя между предметом/участником и объектами/инструментами. Внесение изменений в «я» путем добавления или исключения инструментов может помочь нам понять способ работы этого «я».

Роботы, которые учатся использовать инструменты в качестве дополнения к своему телу, являются очень эффективными экспериментальными площадками для проверки новейших данных и теорий нейробиологии и психологии. Постепенно исследования приведут к разработкам новый, более разумных и когнитивных машин, которые будут работать на (и для) людей в самых различных сферах.

Возможно, именно это является самым важным аспектом исследования. В конечном итоге психология, нейробиология и инженерия объединятся для того, чтобы понять один из самых фундаментальных вопросов науки: «Кто я такой?»

Источник